はじめに

現代では、長大な文書(技術仕様書、法令、研究レポート、報告書など)に対して、自然な質問を投げると、該当する部分を見つけて答えてくれる「RAG(Retrieval-Augmented Generation)」という仕組みが広く使われています。

従来のRAGは、文書を小さな塊(チャンク)に分け、それぞれを数値(ベクトル)に変換して、質問文と「数値的に近い」部分を探す方法が主流でした。

一見便利ですが、この方式には次のような課題があります。

-

文書構造を無視して分割するため、前後のつながりが失われやすい

たとえば「定義」と「注意事項」が別チャンクになると、重要な前提が欠けたまま検索されることがあります。

-

数値的な近さが、必ずしも意味の近さとは限らない

たとえば「AI倫理」と聞かれても、「AI倫理規約」「AI倫理観の欠如」といった文脈違いの部分が引っかかることがあります。

-

どこを根拠にしたかが見えづらい

「第何章のどの節から取ってきたのか」が分からず、検証や再現が難しくなります。

そうした中で、PageIndex は「構造を捉えて探索する方式」でこれらの課題を解決する新しいRAGの手法です。

PageIndex は OSS として公開されていますが、今回はより手軽に試せる 公式のPython SDK を使って動作を確認しました。

本記事では、PageIndex の概要、ベクトルDB型RAGとの比較、典型的なユースケース、そしてPageIndexの使い方を紹介します。

PageIndexとは何か

PageIndex は、文書の構造(章・節・段落)を理解して探索する新しいRAGツールです。

ベクトル類似度だけに頼らず、目次のようなツリー構造をたどって根拠を特定し、回答を生成します。

PageIndex の主な機能は次の3つです。

-

OCR(構造化テキスト抽出)

PDFから文字を認識し、見出し・段落・ページ番号などの構造を保ったMarkdownを生成します。

-

Tree Generation(ツリー生成)

文書全体を章・節の階層ツリーに整理します。各ノードにタイトル・本文・ページ番号が紐づきます。

-

Retrieval(構造探索による検索)

質問に対してツリーを上位から下位へ推論的に探索し、関連ノードを抽出します。

どの章・ページからの抜粋かが明示された回答を生成します。

また、PageIndexには以下のような特長もあります。

- 軽量インフラ:ベクトルDBが不要です。JSONなどの軽い構造化データで扱え、チャンク分割(小分け)も原則不要です。

- 文脈保持:章・節の流れを崩さないため、文脈切断や取りこぼしを防ぎます。

- 根拠の追跡性:回答の根拠(ノード・ページ)が可視化され、検証しやすい設計です。

ベクトルDBとの比較とメリット

PageIndex は「文書構造を保った検索」に強く、ベクトルDB は「大規模で柔軟な検索」に強みがあります。

主な違いを表にまとめました。

| 観点 | ベクトルDB方式 | PageIndex |

|---|---|---|

| 検索方式 | embedding による類似度検索 | 木構造探索 + 推論 |

| 前処理 | 文をチャンクに分割、embedding を計算 | チャンク分割不要、文書構造そのまま利用 |

| 文脈破損 | チャンク境界でつながりが切れることあり | 節や章の流れを保てる |

| 根拠明示性 | 類似度スコアや断片のみ | ノード・ページ番号・探索経路などが明示されやすい |

| インフラコスト | ベクトルDB維持、検索インデックス管理が必要 | 軽い JSON ベース。DB管理の手間が少ない |

| 得意分野 | 短文QA、FAQ、類似検索 | 長文文書、マニュアル、報告書、法令など構造ある文書 |

| パラメータ調整 | Top-K や閾値の設定が必要 | 探索方式中心でチューニングが少なく済む可能性あり |

PageIndexのユースケース

PageIndexのユースケースとして、以下のものが挙げられます。

- 財務報告書

- 法令・契約書・規制文書

- 医療記録・医療文書

- 技術マニュアル

- 研究論文

クラウド版で3つの機能を試す

使用したPDFファイルはこちらです。

1. OCR

こちらのページの「Upload」からPDFをアップロードします。

PDFファイルがOCRできていることを確認できました。

2. Tree Generation

こちらのページで「Tree」を選択します。

文書の見出し構造が自動的に解析され、章や節ごとの階層ツリーが生成されます。

画面のように「AI開発者」「AI提供者」などの項目が整理され、どの内容がどのページにあるかを直感的に確認できます。

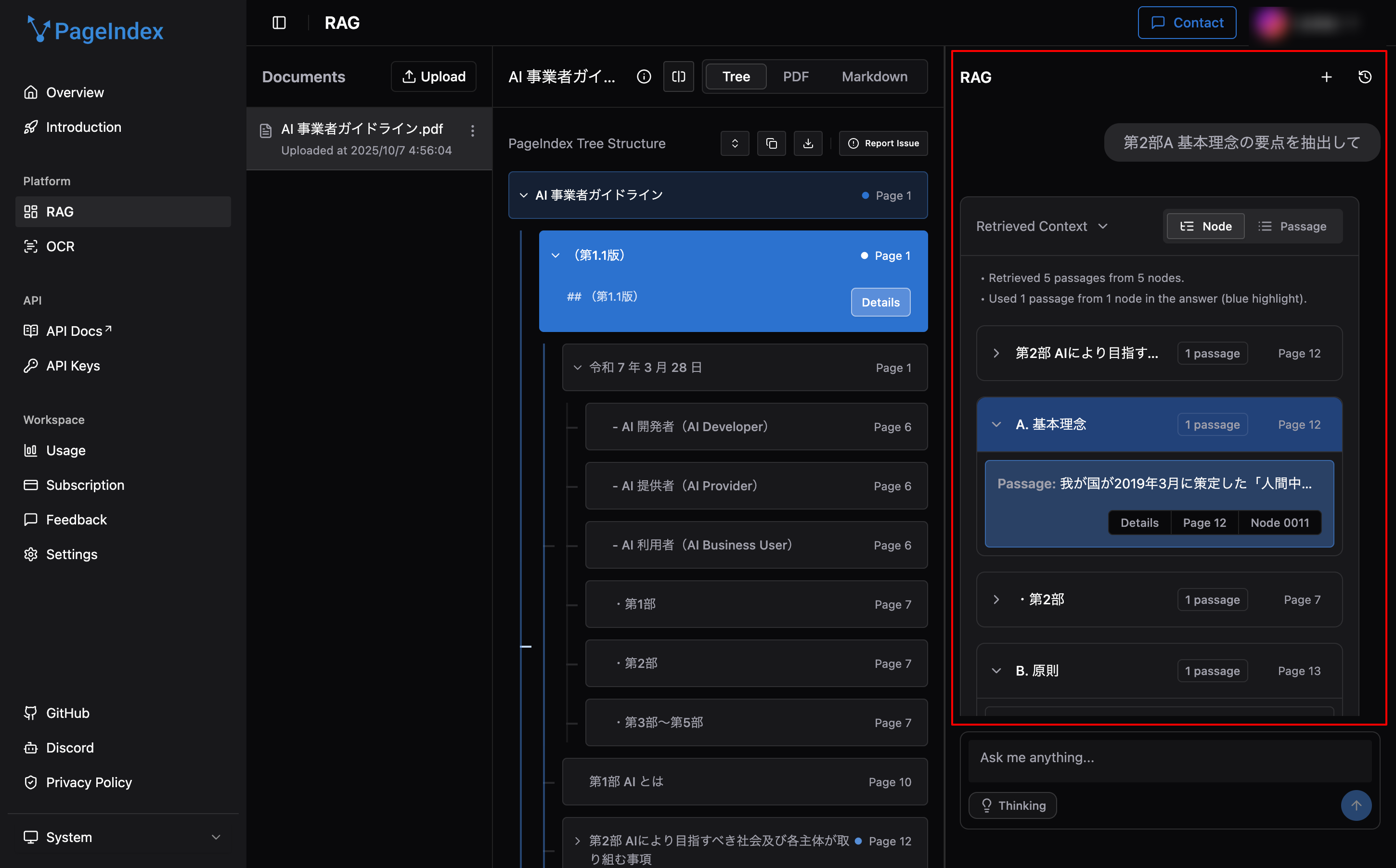

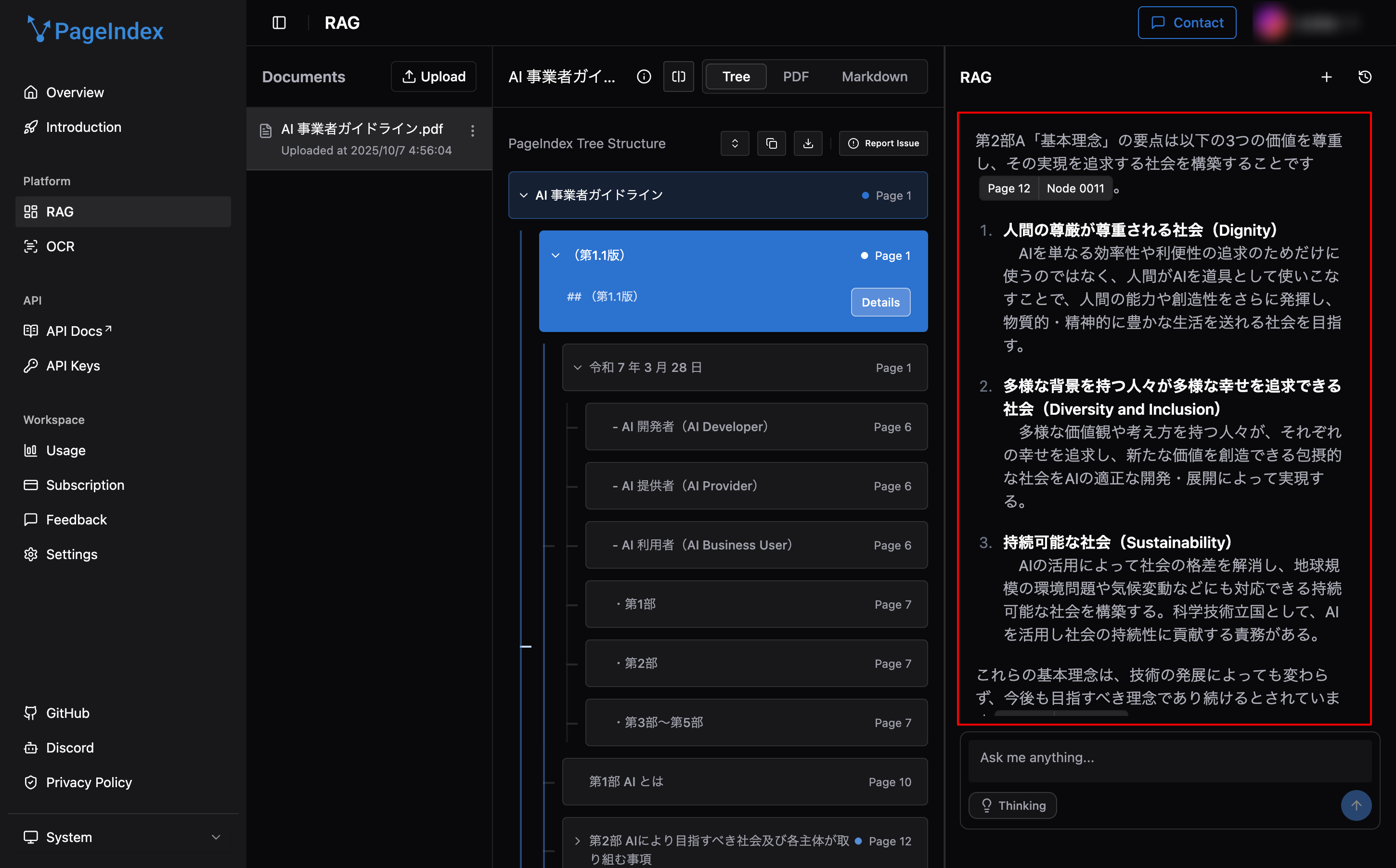

3. Retrieval

質問を入力すると、文書ツリーの中から関連する節や段落を自動で抽出し、右側にハイライト付きで表示されます。

どのページ・どの章から抜粋されたかが一目で分かる形で回答が生成されるため、根拠を確認しながら内容を把握できます。

コードによる実行方法

ここでは Python SDK を使って、PageIndex を実際に動かす方法を紹介します。

1. 事前準備

今回の実行環境は Google Colab です。

Colab 上で Gemini の API キーを環境変数に設定し、Google Drive をマウントしてファイルを扱えるようにします。

ライブラリのインストール

!pip -q install pageindex google-genaiAPI キーの取得

こちらからAPI キーを取得してください。

キー設定とクライアント初期化

import os

from pageindex import PageIndexClient

from google import genai # Gemini SDK

os.environ["PAGEINDEX_API_KEY"] = "YOUR_PAGEINDEX_API_KEY"

os.environ["GOOGLE_API_KEY"] = "YOUR_GOOGLE_API_KEY" # Gemini Developer API

pi = PageIndexClient(api_key=os.environ["PAGEINDEX_API_KEY"])

gclient = genai.Client(api_key=os.environ["GOOGLE_API_KEY"])Google Driveのマウント

from google.colab import drive

drive.mount('/content/drive')2. PDF を登録

このコードでは、PDFファイルを PageIndex のクラウドに送信し、処理対象として登録しています。

pdf_path = "/content/drive/path/to/your/file"

res = pi.submit_document(pdf_path)

doc_id = res["doc_id"]; doc_idコード解説

res = pi.submit_document(pdf_path)

ここでは、PageIndexClient のメソッド submit_document() を使って、指定したPDFファイルをアップロードしています。

この処理が完了すると、PageIndexのクラウド側で文書解析(OCRやTree生成)のジョブが作成され、その結果が res に返されます。

doc_id = res["doc_id"]; doc_id

ここでは、返り値 res に含まれる "doc_id" を取り出しています。

この doc_id は、後続のOCR処理・Tree生成・Retrieval検索などで同じ文書を指定するための識別子(ID)として使われます。

つまり、ここで取得した doc_id が、以降すべてのAPI呼び出しの基準となる重要なキーです。

3. OCR の完了待ちと取得

このコードでは、PDFファイルのOCR(文字認識と構造抽出)処理が完了するまで待機し、その結果を取得しています。

PageIndexのOCRは非同期で実行されるため、処理状態を確認しながら完了を待つ仕組みになっています。

import time

def wait_ocr(doc_id: str, interval: int = 3, fmt: str | None = None):

while True:

o = pi.get_ocr(doc_id) if fmt is None else pi.get_ocr(doc_id, format=fmt)

st = o.get("status")

if st == "completed":

return o

if st == "failed":

raise RuntimeError("OCR failed")

time.sleep(interval)

ocr = wait_ocr(doc_id, fmt="node")

print("OCR status:", ocr["status"])

ocr["result"][:1]コード解説

o = pi.get_ocr(doc_id, format=fmt)

処理中のOCR結果を取得し、ステータスと出力を確認します。fmt="node" で見出し(ノード)単位の構造を受け取ります。

if st == "completed":

return oOCRが完了した時点で結果オブジェクトを返します。

time.sleep(interval)次の確認まで待機し、呼び出し間隔を調整します。

ocr = wait_ocr(doc_id, fmt="node")

完了するまで待機して、最終的なOCR結果を ocr に格納します。

print("OCR status:", ocr["status"])

ocr["result"][:1]ステータスを表示し、結果の先頭要素のみを簡易チェックします(見出し名・階層・ページ番号などを把握できます)。

出力は以下のようになり、OCRできていることが確認できます。

[{'title': 'AI 事業者ガイドライン',

'level': 1,

'page_index': 1,

'text': '# AI 事業者ガイドライン'},

{'title': '(第1.1版)', 'level': 2, 'page_index': 1, 'text': '## (第1.1版)'}]

ここで、"title" は見出しの名称、"level" は見出しの階層レベル、"page_index" は出現ページ、"text" はMarkdown形式で整えられた見出しテキストを示しています。

4. Tree 生成完了待ちと取得

このコードでは、OCR処理によって得られた構造情報をもとに、文書全体の階層構造(ツリー)を取得しています。

PageIndexのTree Generationは、章・節・小節などの関係を階層的に整理し、見出し構造をJSON形式で返す機能です。

def wait_tree(doc_id: str, interval: int = 3):

while True:

t = pi.get_tree(doc_id)

st = t.get("status")

if st == "completed":

return t

if st == "failed":

raise RuntimeError("Tree generation failed")

time.sleep(interval)

tree = wait_tree(doc_id)

print("Tree status:", tree["status"])

len(tree["result"]) # 生成ノード数の目安コード解説

t = pi.get_tree(doc_id)OCRで解析済みの文書に対して、Tree(文書構造)を取得します。

この処理も非同期で実行されるため、結果の "status" を確認しながら完了を待ちます。

if st == "completed":

return t

Treeの生成が完了した時点で、結果オブジェクト t を返します。

このオブジェクトには文書全体の見出し階層が格納されています。

tree = wait_tree(doc_id)

完了を待機し、Tree生成の結果を tree に格納します。

この変数が後続のRetrieval(検索)処理で参照されます。

今回生成された JSON の一部は以下のようになります。

{

"title": "AI 事業者ガイドライン",

"node_id": "0000",

"page_index": 1,

"text": "# AI 事業者ガイドライン\n",

"nodes": [

{

"title": "(第1.1版)",

"node_id": "0001",

"page_index": 1,

"text": "## (第1.1版)\n",

"nodes": [

{

"title": "令和 7 年 3 月 28 日",

"node_id": "0002",

"page_index": 1,

"text": "### 令和 7 年 3 月 28 日\n\n総務省 経済産業省\n\n目次\nはじめに ..... 2\n第1部AIとは ..... 9\n第2部AIにより目指すべき社会及び各主体が取り組む事項 ..... 11\nA. 基本理念 ..... 11\nB. 原則 ..... 12\nC. 共通の指針 ..... 13\nD. 高度なAIシステムに関係する事業者に共通の指針 ..... 25\nE. AIガバナンスの構築 ..... 27\n第3部AI開発者に関する事項 ..... 30\n第4部AI提供者に関する事項 ..... 35\n第5部AI利用者に関する事項 ..... 38\n\nはじめに \n\nAI 関連技術は日々発展をみせ、AI の利用機会及び様々な可能性は拡大の一途をたどり、産業におけるイ ノベーション創出及び社会課題の解決に向けても活用されている。また近年台頭してきた対話型の生成AIによ つて「AI の民主化」が起こり、多くの人が「対話」によってAIを様々な用途へ容易に活用できるようになった。これ により、企業では、ビジネスプロセスにAIを組み込むだけではなく、AIが創出する価値を踏まえてビジネスモデル自体を再構築することにも取り組んでいる。また、個人においても自らの知識をAI に反映させ、自身の生産性を拡大させる取組が加速している。我が国では、従来から Society 5.0 として、サイバー空間とフィジカル空間を高度に融合させたシステム(CPS:サイバー・フィジカルシステム)による経済発展と社会的課題の解決を両立す る人間中心の社会というコンセプトを掲げてきた。このコンセプトを実現するにあたり、AIが社会に受け入れられ適正に利用されるため、2019年3月に「人間中心のAI社会原則」が策定された。一方で、AI 技術の利用範囲及び利用者の拡大に伴い、リスクも増大している。特に生成AI に関して、知的財産権の侵害、偽情報・誤情報の生成・発信等、これまでのAI ではなかったような新たな社会的リスクが生じており、AI がもたらす社会的 リスクの多様化・増大が進んでいる。\n\nそのような背景の中、本ガイドラインは、AIの安全安心な活用が促進されるよう、我が国におけるAI ガバナン スの統一的な指針を示す。これにより、様々な事業活動においてAIを活用する者が、国際的な動向及びステ ークホルダーの懸念を踏まえたAI のリスクを正しく認識し、必要となる対策をAI のライフサイクル全体で自主的に実行できるように後押しし、互いに関係者と連携しながら「共通の指針」と各主体に重要となる事項及びAI ガ バナンスを実践することを通して、イノベーションの促進とライフサイクルにわたるリスクの緩和を両立する枠組みを積極的に共創していくことを目指す。\n\n我が国は 2016 年 4 月の G7 香川・高松情報通信大臣会合におけるAI 開発原則に向けた提案を先駆け とし、G7・G20、OECD 等の国際機関での議論をリードし、多くの貢献をしてきた。一方、AI に関する原則の具体的な実践を進めていくにあたつては、\n\n・少子高齢化に伴う労働力の低下等の社会課題の解決手段として、AI の活用が期待されていること\n・法律の整備・施行がAIの技術発展及びその社会実装のスピード・複雑さとの間でタイムラグが発生す ること\n・細かな行為義務を規定するルールベースの規制を行うと、イノベーションを阻害する可能性があること\n等が指摘されてきた。これらを踏まえ、AI がもたらす社会的リスクの低減を図るとともに、AI のイノベーション及び活用を促進していくために、関係者による自主的な取組を促し、非拘束的なソフトローによって目的達成に導く ゴールベースの考え方で、ガイドラインを作成することとした。\n\nこのような認識のもと、これまでに総務省主導で「国際的な議論のためのAI 開発ガイドライン案」、「AI 利活用ガイドライン〜AI 利活用のためのプラクティカルリファレンス〜」及び経済産業省主導で「AI 原則実践のための ガバナンス・ガイドライン Ver. 1.1」を策定・公表してきた。そして、このたび 3 つのガイドラインを統合・見直しし て、この数年でさらに発展したAI 技術の特徴及び国内外におけるAI の社会実装に係る議論を反映し、事業者がAI の社会実装及びガバナンスを共に実践するためのガイドライン(非拘束的なソフトロー)として新たに策\n\n定した(「図1.本ガイドラインの位置づけ」参照)。従来のガイドラインに代わり、本ガイドラインを参照することで、AIを活用する事業者(政府・自治体等の公的機関を含む)が安全安心なAIの活用のための望ましい行動につながる指針(Guiding Principles)を確認できるものとしている。また、本ガイドラインは、政府が単独で主導するのではなく、教育・研究機関、一般消費者を含む市民社会、民間企業等で構成されるマルチステークホルダーで検討を重ねることで、実効性・正当性を重視したものとして策定されている。\n\n\n\n図1.本ガイドラインの位置づけ\n\nAIの利用は、その分野とその利用形態によっては、社会に対して大きなリスクを生じさせ、そのリスクに伴う社会的な軋轢により、AIの利活用自体が阻害される可能性がある。一方で、過度な対策を講じることは、同様にAI活用自体又はAI活用によって得られる便益を阻害してしまう可能性がある。このような中、予め事前に当該利用分野における利用形態に伴って生じうるリスクの大きさ(危害の大きさ及びその蓋然性)を把握したうえで、その対策の程度をリスクの大きさに対応させる「リスクベースアプローチ」が重要となる。本ガイドラインでは、この「リスクベースアプローチ」にもとづく企業における対策の方向を記載している。なお、この「リスクベースアプローチ」の考え方は、AI先進国間で広く共有されているものである。\n\nまた、AIをめぐる動向が目まぐるしく変化する中、国際的な議論等も踏まえ、本ガイドラインに関しては、AIガバナンスの継続的な改善に向け、アジャイル・ガバナンスの思想を参考にしながら、マルチステークホルダーの関与の下で、Living Documentとして適宜更新を行うことを予定している1。その中で、社会におけるAIの成熟度に応じたリスク及びリスクへの対策となる指針並びに実践の内容の更新を検討する(「図2.本ガイドラインの基本的な考え方」参照)。\n\n<sup>1</sup>総務省のAIネットワーク社会推進会議と経済産業省のAI事業者ガイドライン検討会にて取りまとめを行う。検討体制は、今後の状況に合わせて適宜見直しを行う。\n\n<sup>1</sup>AIネットワーク社会推進会議 https://www.soumu.go.jp/main_sosiki/kenkyu/ai_network/index.html\n\n<sup>1</sup>AI事業者ガイドライン検討会 https://www.meti.go.jp/shingikai/mono_info_service/ai_shakai_ji isso/index.html\n\n\n\n図2.本ガイドラインの基本的な考え方\n\n本ガイドラインは、AI 開発・提供・利用にあたって必要な取組についての基本的な考え方を示すものである。よって、実際の AI 開発・提供・利用において、本ガイドラインを参考の一つとしながら、AI 活用に取り組む全ての事業者が自主的に具体的な取組を推進することが重要となる。同時に、AI 活用に取り組む全ての事業者は、AI が社会にもたらす影響の大きさを認識し、人間社会をよりよいものへと発展させるために活用することを意識すべきである。当該取組に対して、社会から不適切又は不十分と評価される場合は、自らの事業活動における機会損失が生じ、事業価値の維持が困難となる事態を招く恐れがあることに留意することが重要となる。このような点に留意することにより、AI による便益の最大化、競争力の強化、事業価値の維持・向上等が可能となる。なお、AI に関係する事業者以外の者、例えば、教育・研究機関に属する者及び一般消費者(未成年を含む)にとっても、AI の活用にあたって参考となる情報及びリスクに関する情報が盛り込まれているため、有用といえる。\n\n本ガイドラインは、様々な事業活動においてAI の開発・提供・利用を担う全ての者(政府・自治体等の公的機関を含む)を対象としている。他方で、事業活動以外でAI を利用する者又はAI を直接事業で利用せずにAI システム・サービスの便益を享受する、場合によっては損失を被る者(以下、あわせて「業務外利用者」という)については、本ガイドラインの対象には含まない²。ただし、事業活動においてAI の開発・提供・利用を担う者から業務外利用者への必要な対応は記載する。また、AI 活用に伴い学習及び利用に用いるデータが不可欠となる。それらのデータを提供する特定の法人及び個人(以下、「データ提供者」という)も同様に本ガイドラインの対象には含まない。データ収集は色々な方法が考えられる中で、本ガイドラインではデータの提供を受ける者・データを入手する者にあたるAI の開発・提供・利用を担う者がデータを取り扱う際の責任を負う形で記載する。以上より、本ガイドラインの対象者は、AI の事業活動を担う主体として、「AI 開発者」、「AI 提供者」及び「AI 利用者」の3つに大別され、それぞれ以下のとおり定義される。これらの主体は事業者(又は各者内の部\n\n<sup>2</sup>一般消費者がAI、特に生成AIを活用するにあたっての注意点等については、消費者庁「AI 利活用ハンドブック〜生成AI編〜」(2024年5月)を参照。\n\n<https://www.caa.go.jp/policies/policy/consumer_policy/information/ai_handbook>\n\nまた、消費者を支援することに活用できるAIを含むデジタル技術の現状や見通し、課題等については、内閣府「消費者をエンパワーするデジタル技術に関する専門調査会」報告書で整理されている。\n\n<https://www.cao.go.jp/consumer/linkaikouhyou/2024/doc/202412_digital_technology_houkoku.pdf>\n\n門)を想定しており、AIの活用方法によっては同一の事業者がAI開発者、AI 提供者又はAI利用者の複数 を兼ねる場合もある(「図3、一般的なAI活用の流れにおける主体の対応」参照) ${ }^{3}$ 。\n",

"nodes": [

{

"title": "- AI 開発者(AI Developer)",

"node_id": "0003",

"page_index": 6,

"text": "#### - AI 開発者(AI Developer)\n\nAIシステムを開発する事業者(AIを研究開発する事業者を含む)\nAIモデル・アルゴリズムの開発、データ収集(購入を含む)、前処理、AIモデル学習及び検証を通して AIモデル、AIモデルのシステム基盤、入出力機能等を含むAIシステムを構築する役割を担う。\n"

},

{

"title": "- AI 提供者(AI Provider)",

"node_id": "0004",

"page_index": 6,

"text": "#### - AI 提供者(AI Provider)\n\nAIシステムをアプリケーション、製品、既存のシステム、ビジネスプロセス等に組み込んだサービスとしてAI利用者(AI Business User)、場合によっては業務外利用者に提供する事業者\nAIシステム検証、AIシステムの他システムとの連携の実装、AIシステム・サービスの提供、正常稼働のた めのAIシステムにおけるAI利用者(AI Business User)側の運用サポート又はAIサービスの運用自体を担う。AIサービスの提供に伴い、様々なステークホルダーとのコミュニケーションが求められることもあ る。\n"

},

{

"title": "- AI 利用者(AI Business User)",

"node_id": "0005",

"page_index": 6,

"text": "#### - AI 利用者(AI Business User)\n\n事業活動において、AIシステム又はAIサービスを利用する事業者\nAI 提供者が意図している適正な利用を行い、環境変化等の情報をAI 提供者と共有し正常稼働を継続すること又は必要に応じて提供されたAIシステムを運用する役割を担う。また、AIの活用において業務外利用者に何らかの影響が考えられる場合*は、当該者に対するAIによる意図しない不利益の回避、AIによる便益最大化の実現に努める役割を担う。\n\n[^0]\n[^0]: ${ }^{3}$ 開発・提供・利用の対象に生成AIも含まれる。AI 提供者又はAI利用者が政府・自治体等、公的機関になる場合は、民間事業者の場合と は別の考えが必要になる可能性がある。\n ${ }^{4}$ 業務外利用者は、AI 利用者の指示及び注意に従わない場合、何らかの被害を受ける可能性があることを留意する必要がある。\n\n\n\n図 3. 一般的な AI 活用の流れにおける主体の対応\n\n自らが該当する「AI 開発者」、「AI 提供者」又は「AI 利用者」の立場から、「ステークホルダーからの期待を鑑みつつどのような社会を目指すのか(「基本理念」= why)」を踏まえ、「AI に関しどのような取組を行うべきか(指針 = what)」を明らかにすることが重要であり、また指針を実現するために、「具体的にどのようなアプローチで取り組むか(実践 = how)」を検討・決定し、実践することが AI の安全安心な活用に有用と考えられる。実際の AI システム・サービスは目的・活用技術・データ・利用環境等によって多様なユースケースとなり、技術の発展等、外部環境の変化も踏まえつつ、AI 開発者、AI 提供者及び AI 利用者が連携して最適なアプローチを検討することが重要である。本ガイドラインは読みやすさを考慮し、本編で「基本理念」及び「指針」を扱い、別添(付属資料)で「実践」を扱うこととする。\n\n「基本理念」及び「指針」を扱う本ガイドラインの本編の構成を以下に記載する。\n"

},

{

"title": "・第1部",

"node_id": "0006",

"page_index": 7,

"text": "#### ・第1部\n\n本ガイドラインの内容に関する理解を助けるために、「用語の定義」を中心に記載する。\n"

},

{

"title": "・第2部",

"node_id": "0007",

"page_index": 7,

"text": "#### ・第2部\n\nAI の活用により目指すべき社会及びそれを実現するための「基本理念」(why)、並びに原則及び各主体に共通する指針(what)を記載する。AI の活用による便益を求める中で、AI が社会にリスクをもたらす可能性を鑑み、「共通の指針」を実践するために必要となるガバナンスの構築についても触れる。第2部では第3部以降のもととなる内容を解説しているため、AI を活用する全ての事業者が内容を確認し、理解することが重要である。\n"

},

{

"title": "・第3部〜第5部",

"node_id": "0008",

"page_index": 7,

"text": "#### ・第3部〜第5部\n\nAI を活用した事業活動を担う3つの主体に関し、第2部では触れられない主体毎の留意点を記載する。AI を活用する事業者は自らに関する事項を理解することが重要であり、それと同時に、隣接する主体の役割を担うことができる。\n\n体と関係する事項が多く存在するため、当該主体以外に関する事項も理解することが重要である(「図4.本ガイドラインの構成」参照)。\n\n「AI開発者」、「AI提供者」及び「AI利用者」においては、第1部、第2部に加えて、第3部以降の当該部及び別添(付属資料)を確認することで、AIを活用する際のリスク及びその対応方針の基本的な考え方を把握することが可能となる。特に具体的な取組が決まっていない事業者にとっては、別添の記載例が参考となるため、別添の関連箇所を中心とした確認が重要となる。なお、経営者を含む事業執行責任者は、その職務を全うするために、本ガイドラインにおける「基本理念」(why)及び指針(what)を踏まえて、事業戦略と一体でAIを活用する際のリスク対策を検討・実践し、AIの安全安心な活用を推進することが重要である。\n\n\n\n図4.本ガイドラインの構成\n\nAIをめぐる環境はグローバル規模で日進月歩の進化を続けていることから、AIを活用する事業者は、国際的な動向にも注意を払うことが重要である。我が国においても、こうした現状を踏まえ、広島AIプロセスを通じて、AIに関する国際的な共通理解及び指針の策定を主導しており、2023年12月には広島AIプロセス包括的政策枠組み等を取りまとめた。本ガイドラインも同プロセスへの貢献を意図するとともに、同プロセスを含む国際的な共通理解及び指針の策定を主導しており、2023年12月には広島AIプロセス包括的政策枠組み等を取りまとめた。さらに、2024年には、3月の「G7産業・技術・デジタル大臣会合」、10月の「G7デジタル・技術大臣会合」を経て、国際行動規範の遵守状況に係る「報告枠組み」が、同年12月にG7で合意された。https://www.soumu.go.jp/hiroshimaaiprocess/2023/01/10/000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000\n\n的な議論を踏まえながら検討したものである。一方で、AIをめぐる考え方及び法令は国・地域で異なることから、特に、国境を越えた活動を行う事業者は、現地の法令に対応すべきであり、ステークホルダーの要望に応じた対応が期待される。特に高度なAIシステムについては市場に導入される前の安全性評価8の枠組みを検討する等、国・地域によってはガバナンスの実効性を担保するための措置を講じている場合もあり、注意を払うことが重要である。9\n\nし、広島 AI プロセスの推進にも協力している生成AIに関するプロジェクトをはじめとした運営・管理面での支援を提供するため、2024年7月に「GPAI 東京専門家支援センター」を国立研究開発法人情報通信研究機構(NICT)に設置。同センターでは、これまでにSAFEプロジェクト(生成AIの安全性を保証するための実践的なアプローチの調査)を展開してきたほか、OECDと協議しながら新たな生成AI関連プロジェクトを実施していくこととしている。\n\nhttps://www2.nict.go.jp/gpai-tokyo-esc/\n\n8 2023年11月、英国では、高度なAIシステムの評価の開発、実施等を行う「AI Safety Institute」の設置計画を発表し、米国では、米国標準技術研究所(NIST)にAIリスクマネジメントフレームワークの実装、レッドチーミングの評価等を行う「US AI Safety Institute」を設立することを発表した。なお、英国では、2025年2月に、AI Safety InstituteからAI Security Instituteに改称されている。日本においても、これらの海外機関と連携しつつ、AIの開発・提供・利用の安全性向上に資する基準・ガイダンス等の検討、AIの安全性評価方法等の調査、AIの安全性に関する技術・事例の調査等を目的とし、2024年2月14日に、関係府省庁及び関係機関の協力の下、「AIセーフティ・インスティテュート」を独立行政法人情報処理推進機構(IPA)に設置。本ガイドラインと米国NISTAIリスクマネジメントフレームワーク(RMF)のクロスウォークや「AIセーフティに関する評価観点ガイド」(2024年9月)https://aisi.go.jp/effort/effort_framework/guide_to_evaluation_perspective_on_ai_safety/の公表、各国のAISI等との連携・意見交換、各種調査等の活動を実施している。https://aisi.go.jp/9 2025年2月4日に、AI戦略会議・AI制度研究会中間とりまとめが公表された。https://www8.cao.go.jp/cstp/ai/interim_report.pdf\n"

}

]

},

{

"title": "第1部 AI とは",

"node_id": "0009",

"page_index": 10,

"text": "### 第1部 AI とは\n\nAI は Artificial Intelligence(人工知能)を意味し、1956年にダートマス会議で初めて使用された言葉 であるとされている。AI は未だ確立された定義は存在しないが、「人工」「知能」とあるように、人間の思考プロセ スと同じような形で動作するコンピュータープログラム、コンピューター上で知的判断を下せるシステム等を指す。機械学習(Machine Learning、略してML)を行わない、専門家の知識を大量にインプットすることで知識にもと づく推論を行うエキスパートシステムと呼ばれるものも、AI とみなす考えもある。しかし、2000年代以降、ディープ ラーニング等による「画像認識」「自然言語処理(翻訳等)」「音声認識」が活用されるようになり、特定の分野に特化し、予測、提案又は決定を行うことができるシステムをAI と指すようになってきた。また、2021年以降、基盤モデル ${ }^{10}$ の台頭により、特定の分野のみに特化したAIではない、汎用的なAI の開発が進んでいる。そ の結果、「予測」「提案」「決定」にとどまらず、画像、文章等を生成する「生成AI」が普及するようになり、注目を集めている。このように、ひとくくりに「AI」と言っても、その種類は多岐にわたり、今後のAI 技術の在り方につ いては専門家であっても予測することは困難である。\n\nこのような状況を踏まえつつ、本ガイドラインにおける関連する用語を以下のとおり定義する。\n\n関連する用語\n\n・AI\n現時点で確立された定義はなく(統合イノベーション戦略推進会議決定「人間中心のAI社会原則」\n(2019 年 3 月 29 日))、広義の人工知能の外延を厳密に定義することは困難である。本ガイドライ ンにおけるAI は「AI システム(以下に定義)」自体又は機械学習をするソフトウェア若しくはプログラム を含む抽象的な概念とする。\n(参考としてJIS X 22989:2023 では ISO/IEC 22989:2022 にもとづき、以下のように定義されてい る)\n<学問分野>AIシステムのメカニズム及び適用の研究開発\n注釈 1. 研究開発は、コンピュータサイエンス、データサイエンス、自然科学、人文科学、数学等、幾つも の分野にわたって行うことが可能である\n"

},

{

"title": "・AIシステム",

"node_id": "0010",

"page_index": 10,

"text": "### ・AIシステム\n\n活用の過程を通じて様々なレベルの自律性をもって動作し学習する機能を有するソフトウェアを要素とし て含むシステムとする(機械、ロボット、クラウドシステム等)。\n(参考としてJIS X 22989:2023 では ISO/IEC 22989:2022 にもとづき、以下のように定義されてい る)\n人間が定義した所与の目標の集合に対して、コンテンツ、予測、推奨、意思決定等の出力を生成する工学的システム\n注釈 1. 工学的システムは、人工知能に関連する様々な技法及びアプローチを使用して、作業の実施\n\n[^0]\n[^0]: ${ }^{10}$ 大規模言語モデルに代表される基盤モデルは、様々なサービスを支える個別モデルを生み出すコアの技術基盤である。基盤モデルから派生する下流の幅広いタスクに適応させたモデルの開発、開発過程そのものから得られる知見等の観点から、一般的なAI とは異なる性質を持つ。\n\nに使用可能であるデータ、知識、プロセス等を表すモデルを開発することが可能である\n注釈 2. AI システムは、様々な自動化のレベルで動作するように設計されている\n(参考として OECD AI Principles overview では以下のように定義されている)\nAI システムは、明示的又は暗黙的な目的のために推測するマシンベースのシステムである。受け取った入力から、物理環境又は仮想環境に影響を与える可能性のある予測、コンテンツ、推奨、意思決定等 の出力を生成する。AIシステムが異なれば、導入後の自律性及び適応性のレベルも異なる\n\n#### - 高度なAIシステム\n\n最先端の基盤モデル及び生成 AI システムを含む、最も高度なAIシステムを指す。\n(広島AIプロセスでの定義を引用)\n\n#### - AI モデル(ML モデル)\n\nAI システムに含まれ、学習データを用いた機械学習によって得られるモデルで、入力データに応じた予測結果を生成する。\n(参考として JIS X 22989:2023 では ISO/IEC 22989:2022 にもとづき、以下のように定義されてい る)\n入力データ又は情報にもとづいて推論(inference)又は予測を生成する数学的構造\n例:単変量線形関数 $y=0_{0}+\\theta_{1} x$ が、線形回帰を使用して訓練されている場合、結果のモデルは、 $y=3+7 x$ のようになる\n注釈 1. 機械学習モデルは、機械学習アルゴリズムにもとづく訓練の結果として得られる\n\n#### - AI サービス\n\nAI システムを用いた役務を指す。AI 利用者への価値提供の全般を指しており、AIサービスの提供・運営は、AIシステムの構成技術に限らず、人間によるモニタリング、ステークホルダーとの適切なコミュニケー ション等の非技術的アプローチも連携した形で実施される。\n\n#### - 生成AI\n\n文章、画像、プログラム等を生成できるAIモデルにもとづくAIの総称を指す。\n\n#### - AI ガバナンス\n\nAI の利活用によって生じるリスクをステークホルダーにとって受容可能な水準で管理しつつ、そこからもたら される正のインパクト(便益)を最大化することを目的とする、ステークホルダーによる技術的、組織的、及び社会的システムの設計並びに運用。\n"

},

{

"title": "第2部 AIにより目指すべき社会及び各主体が取り組む事項",

"node_id": "0011",

"page_index": 12,

"text": "### 第2部 AIにより目指すべき社会及び各主体が取り組む事項\n\n第2部では、まず、AIにより目指す社会としての「A. 基本理念」を記載する。更に、その実現に向け、各主体が取り組む「B. 原則」とともに、そこから導き出される「C. 共通の指針」を記載する。また、高度なAIシステム に関係する事業者が遵守すべき「D. 高度なAIシステムに関係する事業者に共通の指針」を記載する。加え て、この「C. 共通の指針」を実践しAIを安全安心に活用していくために重要な「E. AI ガバナンスの構築」につい ても記載する。\n",

"nodes": [

{

"title": "A. 基本理念",

"node_id": "0012",

"page_index": 12,

"text": "#### A. 基本理念\n\n「はじめに」で述べたとおり、我が国が 2019 年 3 月に策定した「人間中心のAI社会原則」においては、AIが Society 5.0 の実現に貢献することが期待されている。また、AIを人類の公共財として活用し、社会の在り方の質的変化及び真のイノベーションを通じて地球規模の持続可能性とつなげることが重要であることが述べられて いる。そして、以下の 3 つの価値を「基本理念」として尊重し、「その実現を追求する社会を構築していくべき」と している。\n\n(1) 人間の尊厳が尊重される社会(Dignity)\n\nAIを利活用して効率性や利便性を追求するあまり、人間がAIに過度に依存したり、人間の行動を コントロールすることにAIが利用される社会を構築するのではなく、人間がAIを道具として使いこなす ことによって、人間の様々な能力をさらに発揮することを可能とし、より大きな創造性を発揮したり、や りがいのある仕事に従事したりすることで、物質的にも精神的にも豊かな生活を送ることができるよう な、人間の尊厳が尊重される社会を構築する必要がある\n\n(2) 多様な背景を持つ人々が多様な幸せを追求できる社会\n\n(Diversity and Inclusion)\n\n多様な背景、価値観又は考え方を持つ人々が多様な幸せを追求し、それらを柔軟に包摂した上で新たな価値を創造できる社会は、現代における一つの理想であり、大きなチャレンジである。AIという強力な技術は、この理想に我々を近づける一つの有力な道具となりうる。我々はAIの適正な開発と展開によって、このように社会の在り方を変革していく必要がある\n\n(3) 持続可能な社会(Sustainability)\n\n我々は、AIの活用によりビジネスやソリューションを次々と生み、社会の格差を解消し、地球規模の環境問題や気候変動等にも対応が可能な持続性のある社会を構築する方向へ展開させる必要が ある。科学・技術立国としての我が国は、その科学的・技術的蓄積をAIによって強化し、そのような社会を作ることに貢献する責務がある\n\n人間の尊厳が尊重される社会 (Dignity) \n\n基本理念\n\n多様な特徴を持つ人々が\n\n多様な等性を追求できる社会 (Diversity \\& Inclusion)\n\n持続可能な社会 (Sustainability)\n\n図 5. 基本理念\n\nこの基本的な考え方自体は、著しい技術の発展によっても変わるものではなく、目指すべき理念であり続けて いる。したがって、AIの発展に伴い、日本及び多国間の枠組みで目指すべき方向性として、これらの「基本理念」が尊重されるべきである。\n"

},

{

"title": "B. 原則",

"node_id": "0013",

"page_index": 13,

"text": "#### B. 原則\n\n「基本理念」を実現するためには、各主体がこれに沿う形で取組を進めることが重要であり、そのために各主体が念頭におく「原則」を、各主体が取り組む事項及び社会と連携した取組が期待される事項に整理した。こ の「原則」は、「人間中心の AI 社会原則」を土台としつつ、OECD の AI 原則等の海外の諸原則を踏まえ、再構成したものである。\n\n各主体が取り組む事項\n\n各主体は、「基本理念」より導き出される人間中心の考え方をもとに11、AIシステム・サービスの開発・提供・利用を促進し、人間の尊厳を守りながら、事業における価値の創出、社会課題の解決等、AI の目的を実現し ていくことが重要である。このため、各主体は、AI 活用に伴う社会的リスクの低減を図るべく、安全性・公平性と いった価値を確保することが重要である。また、個人情報の不適正な利用等の防止を始めとするプライバシー保護、並びにAIシステムの脆弱性等による可用性の低下及び外部からの攻撃等のリスクに対応するセキュリティ確保を行うことが重要である。これらを実現するために、各主体は、システムの検証可能性を確保しながらステー クホルダー12に対する適切な情報を提供することにより透明性を向上させ、アカウンタビリティを果たすことが重要と なる。\n\n[^0]\n[^0]: ${ }^{11}$ 下線部は、後段の「C. 共通の指針」として整理されるものである。\n 12 ステークホルダー:AI 開発者、AI 提供者、AI 利用者及び業務外利用者以外の第三者を含むAIの活用によって直接・間接の影響を受ける可能性がある全ての主体(以降同様)\n\n加えて、今後、AIアーキテクチャの多様化に伴うバリューチェーン変動等により、各主体の役割が変動する可能性を踏まえた上で、各主体間で連携し、バリューチェーン全体でのAIの品質の向上に努めること及びマルチス テークホルダーで継続して議論していくことが重要である。\n\nこのような対応を行うことで、各主体が、AIのリスクを最低限に抑制しつつ、AIシステム・サービスの開発・提供・利用を通じて最大限の便益を享受することが期待される。\n\n社会と連携した取組が期待される事項 \n\nAIによる社会への便益を一層増大させ、我々が目指すべき「基本理念」を実現していくためには、各主体そ れぞれの取組に加え、社会(政府・自治体及びコミュニティも含む)と積極的に連携することが期待される。こ のため、各主体は、社会と連携して、社会の分断を回避し、全ての人々にAIの恩恵が行き渡るための教育・リ テラシー確保の機会を提供することが期待される。加えて、新たなビジネス・サービスが創出され、持続的な経済成長の維持及び社会課題の解決策が提示されるよう、公正競争の確保及びイノベーションの促進に貢献して いくことが期待される。\n"

},

{

"title": "C. 共通の指針",

"node_id": "0014",

"page_index": 14,

"text": "#### C. 共通の指針\n\n取組にあたり、各主体は、以下に述べる「1)人間中心」に照らし、法の支配、人権、民主主義、多様性・包摂性及び公平公正な社会を尊重するようAIシステム・サービスを開発・提供・利用すべきである。また、憲法、知的財産関連法令及び個人情報保護法をはじめとする関連法令、AIに係る個別分野の既存法令等を遵守すべきであり、国際的な指針等の検討状況についても留意することが重要である ${ }^{13}$ 。\n\nなお、これらの取組は、各主体が開発・提供・利用するAIシステム・サービスの特性、用途、目的及び社会的文脈を踏まえ、各主体の資源制約を考慮しながら自主的に進めることが重要である。\n\n各主体が連携して、バリューチェーン全体で取り組むべきことは、具体的には、以下のとおり整理される。\n"

},

{

"title": "1) 人間中心",

"node_id": "0015",

"page_index": 14,

"text": "#### 1) 人間中心\n\n各主体は、AIシステム・サービスの開発・提供・利用において、後述する各事項を含む全ての取り組む べき事項が導出される土台として、少なくとも憲法が保障する又は国際的に認められた人権を侵すことが ないようにすべきである。また、AIが人々の能力を拡張し、多様な人々の多様な幸せ(well-being)の追求が可能となるように行動することが重要である。\n\n① 人間の尊厳及び個人の自律\n$\\diamond \\quad$ AIが活用される際の社会的文脈を踏まえ、人間の尊厳及び個人の自律を尊重する\n$\\diamond$ 特に、AIを人間の脳・身体と連携させる場合には、その周辺技術に関する情報を踏まえつつ、諸外国及び研究機関における生命倫理の議論等を参照する\n\n[^0]\n[^0]: ${ }^{13}$ 事業の地理的な展開状況、開発されたAIモデルを用いるAI提供者・AI利用者の所在地、学習を行うサーバの所在地等に応じ、各準拠法 に従う必要がある。我が国の国内法に準拠する場合は、データの類型に応じ、個人情報、知的財産権等にそれぞれ適用される法令に適合した取扱を行う。また、データの取扱においては、法令で定められていなくともステークホルダー間の契約関係において、利用が禁止される場合が存在す ることにも留意すべきである。\n\n> 個人の権利・利益に重要な影響を及ぼす可能性のある分野において AI を利用したプロファイリングを行う場合、個人の尊厳を尊重し、アウトプットの正確性を可能な限り維持させつつ、AI の予測、推奨、判断等の限界を理解して利用し、かつ生じうる不利益等を慎重に検討した上で、不適切な目的に利用しない\n\n- ② AI による意思決定・感情の操作等への留意\n - 人間の意思決定、認知等、感情を不当に操作することを目的とした、又は意識的に知覚できないレベルでの操作を前提とした AI システム・サービスの開発・提供・利用は行わない\n - AI システム・サービスの開発・提供・利用において、自動化バイアス<sup>14</sup> 等の AI に過度に依存するリスクに注意を払い、必要な対策を講じる<sup>15</sup>\n - フィルターバブル<sup>16</sup> に代表されるような情報又は価値観の傾斜を助長し、AI 利用者を含む人間が本来得られるべき選択肢が不本意に制限されるような AI の活用にも注意を払う\n - 特に、選挙、コミュニティでの意思決定等をはじめとする社会に重大な影響を与える手続きに関連しうる場合においては、AI の出力について慎重に取り扱う\n\n- ③ 偽情報等への対策\n - 生成 AI によって、内容が真実・公平であるかのように装った情報を誰でも作ることができるようになり、AI が生成した偽情報・誤情報・偏向情報が社会を不安定化・混乱させるリスクが高まっていることを認識した上で、必要な対策を講じる<sup>17,18</sup>\n\n- ④ 多様性・包摂性の確保\n - 公平性の確保に加え、いわゆる「情報弱者」及び「技術弱者」を生じさせず、より多くの人々が AI の恩恵を享受できるよう社会的弱者による AI の活用を容易にするよう注意を払う\n - ユニバーサルデザイン、アクセシビリティの確保、関連するステークホルダー<sup>19</sup> への教育・フォローアップ 等\n\n- ⑤ 利用者支援\n\n<sup>14</sup> 人間の判断や意思決定において、自動化されたシステムや技術への過度の信頼や依存が生じる現象を指す。\n\n<sup>15</sup> 必要な対策としては、AI による評価、判断、推奨、又は予測等のアウトプットを人間が鵜呑みにしないために、AI の欠点を含む特性を理解できるトレーニングを受けることや、AI の評価や判断等を人間が承認する際には人間自身が AI の評価や判断等を承認する理由や根拠を独自に考えてから承認すべきこと等が提案されている。\n\n<sup>16</sup> 「フィルターバブル」とは、アルゴリズムがネット利用者個人の検索履歴やクリック履歴を分析し学習することで、個々にとっては望むと望まざるをえにかかわらず見たい情報が優先的に表示され、利用者の観点に合わない情報からは隔離され、自身の考え方や価値観の「バブル(泡)」の中に孤立するという情報環境を指す。このようなもともとある人間の傾向とネットメディアの特性の相互作用による現象と言われているものとして、「フィルターバブル」の他、「エコーチェンバー」も挙げられる。そういったリスクがある一方で、AI はパーソナライズされた的を絞った返答を AI 利用者や業務外利用者に提供し、有益な形で提案を行うことを可能とするという便益もある。\n\n<sup>17</sup> インターネット上の偽・誤情報の流通・拡散への対応を含む、デジタル空間における情報流通の健全性確保に向けた今後の対応方針と具体的な方策について検討するため、「デジタル空間における情報流通の健全性確保の在り方に関する検討会」が総務省において開催され、2024 年 9 月に「とりまとめ」が公表された。(https://www.soumu.go.jp/menu_news/s-news/01ryutsu02_02000417.html)また、技術的対応として、総務省により「インターネット上の偽・誤情報等対策技術の開発・実証事業」が実施されている。(https://www.soumu.go.jp/menu_news/s-news/01ryutsu02_02000415.html)\n\n<sup>18</sup> RAG(検索拡張生成)の活用等により、パルシネーションの抑制や出力過程・根拠の透明性向上等が期待されている。\n\n<sup>19</sup> 関連するステークホルダー:AI 開発者、AI 提供者、AI 利用者及び業務外利用者を含む直接・間接問わず AI の活用に関与する主体(以降同様)\n\n合理的な範囲で、AIシステム・サービスの機能及びその周辺技術に関する情報を提供し、選択の機会の判断のための情報を適時かつ適切に提供する機能が利用可能である状態とする\n・デフォルトの設定、理解しやすい選択肢の提示、フィードバックの提供、緊急時の警告、エ ラーへの対処等\n(6) 持続可能性の確保\n$\\diamond \\mathrm{AI}$ システム・サービスの開発・提供・利用において、ライフサイクル全体で、地球環境への影響も検討する(特に、生成AI など計算量の多いAIシステムにおいては、モデルの軽量化や目的に応じたモデルの使い分け等の対策を講じる)\n\nこれら全てを前提とした上で、各主体は、AIのパフォーマンス(有用性)を可能な範囲で高め、人々に便益及び豊かさを与え、幸福を実現することが期待される。\n"

},

{

"title": "2) 安全性",

"node_id": "0016",

"page_index": 16,

"text": "#### 2) 安全性\n\n各主体は、AIシステム・サービスの開発・提供・利用を通じ、ステークホルダーの生命・身体・財産に危害を及ぼすことがないようにすべきである。加えて、精神及び環境に危害を及ぼすことがないようにすることが重要である。\n(1) 人間の生命・身体・財産、精神及び環境への配慮\n$\\diamond$ AIシステム・サービスの出力の正確性を含め、要求に対して十分に動作している(信頼性)\n$\\diamond$ 様々な状況下でパフォーマンスレベルを維持し、無関係な事象に対して著しく誤った判断を発生させないようにする(堅牢性(robustness))\n$\\diamond$ AI の活用又は意図しないAI の動作によって生じうる権利侵害の重大性、侵害発生の可能性等、当該AIの性質・用途等に照らし、必要に応じて定期的かつ客観的なモニタリング及び対処も含めて人間がコントロールできる制御可能性を確保する\n$\\diamond$ 適切なリスク分析を実施し、リスクへの対策(回避、低減、移転又は容認)を講じる\n$\\diamond$ 人間の生命・身体・財産、精神及び環境へ危害を及ぼす可能性がある場合は、講ずべき措置について事前に整理し、ステークホルダーに関連する情報を提供する\n・関連するステークホルダーが講ずべき措置及び利用規則を明記する\n$\\diamond$ AIシステム・サービスの安全性を損なう事態が生じた場合の対処方法を検討し、当該事態が生じた場合に速やかに実施できるよう整える\n(2) 適正利用\n$\\diamond$ 主体のコントロールが及ぶ範囲で本来の目的を逸脱した提供・利用20により危害が発生するこ とを避けるべく、AIシステム・サービスの開発・提供・利用を行う\n$\\diamond$ マルチモーダルな生成AIを中心とするAIシステム・サービスの生成物については、比較的容易 により精巧な生成物の生成が可能となるため、その精巧さにより誤解や偏見等を助長する可能\n\n[^0]\n[^0]: ${ }^{20}$ なお、RAG(検索拡張生成)を活用した場合には生成AIによる回答の収束が加速する可能性が高いため、例えばコンテンツの多様性・独創性を必要とする業務については、RAG(検索拡張生成)の活用が適切ではない場合もあることに留意が必要である。\n\n性があることや、他者の知的財産権等を侵害する可能性があること等にも留意しつつ、その利用に際し人間の判断を介在させる等 ${ }^{21}$ の対策を講じる22\n(3) 適正学習 ${ }^{23}$\n$\\diamond \\mathrm{Al}$ システム・サービスの特性及び用途を踏まえ、学習等に用いるデータの正確性・必要な場合 には最新性(データが適切であること)等を確保する\n$\\diamond$ 学習等に用いるデータの透明性の確保、法的枠組みの遵守、AIモデルの更新等を合理的な範囲で適切に実施する\n$\\diamond$ 権利侵害複製物等の違法なコンテンツ24や情報等を学習データに含めないこと等に留意する25\n"

},

{

"title": "3) 公平性",

"node_id": "0017",

"page_index": 17,

"text": "#### 3) 公平性\n\n各主体は、AIシステム・サービスの開発・提供・利用において、特定の個人ないし集団への人種、性別、国籍、年齢、政治的信念、宗教等の多様な背景を理由とした不当で有害な偏見及び差別をなくす よう努めることが重要である。また、各主体は、それでも回避できないバイアスがあることを認識しつつ、この回避できないバイアスが人権及び多様な文化を尊重する観点から許容可能か評価した上で、AIシステ ム・サービスの開発・提供・利用を行うことが重要である。26\n\n(1) AIモデルの各構成技術に含まれるバイアスへの配慮\n\n[^0]\n[^0]: ${ }^{21}$ 人間の判断を介在させるための工夫としては、生成物であることを示す透かしを入れることやユーザーインタフェースの改善等があげられる。\n ${ }^{22}$ なお、プログラムコードを生成するAIを活用する場合は、生成したコードの安全性やセキュリティ面への配慮が重要となる。\n ${ }^{23}$ AI 提供者・AI 利用者においてもファインチューニング、再学習を行う場合はAI開発者と同様に安全性の担保に努めることが重要となる。\n ${ }^{24}$ 文化庁「AI と著作権に関する考え方について」(文化審議会著作権分科会法制度小委員会、2024年3月)において、海賊版等、違法に アップロードされているものも学習されてしまうことが権利者の懸念として挙げられている。\n ${ }^{25}$ 知的財産関連法令との関係については内閣府、文化庁等での議論が進められており、今後の検討状況についても留意すべきである。特にAI と著作権に関する考え方については、文化審議会著作権分科会法制度小委員会にて取りまとめており、各主体においては、その趣旨を踏まえた対応方針を検討することが重要となる。\n $\\cdot$文化庁「AI と著作権に関する考え方について」(文化審議会著作権分科会法制度小委員会、2024年3月)\n https://www.bunka.go.jp/seisaku/bunkashingikai/chosakuken/pdf/94037901_01.pdf\n $\\cdot$内閣府「AI 時代の知的財産権検討会 中間とりまとめ」(知的財産戦略推進事務局、2024年5月)\n https://www.kantei.go.jp/jp/singi/titeki2/chitekizaisan2024/0528_ai.pdf\n $\\cdot$文化庁「AI と著作権に関するチェックリスト&ガイダンス」(文化庁著作権課、2024年7月)\n https://www.bunka.go.jp/seisaku/chosakuken/pdf/94097701_01.pdf\n $\\cdot$内閣府「AI 時代の知的財産権検討会 中間とりまとめ 手引き(権利者向け)」(知的財産戦略推進事務局、2024年11月)\n https://www.kantei.go.jp/jp/singi/titeki2/chitekizaisan2024/2411_tebiki.pdf\n なお、「AI 時代の知的財産権検討会 中間とりまとめ」及び「AI と著作権に関するチェックリスト&ガイダンス」では、本ガイドラインと異なり、「AI 開発者」、「AI 提供者」及び「AI 利用者」に加えて、「業務外利用者(一般利用者)」及び「権利者」も対象にして、各主体に期待される取組事項例等を整理している。\n ${ }^{26}$ 「バイアス」という言葉には例えば以下の通り様々な解釈が考えられ、本ガイドラインではそれらを総称したものとして用いている。\n $\\cdot$統計的な用語(サンプリングバイアス。偏り・偏差など。)\n $\\cdot$心理学的な用語(認知バイアス(思い込み等に起因。集団ごとの社会通念等による社会的バイアスも含む)、感情バイアス(人間の感情・都合等に起因)など。)\n また NIST の Proposal for Identifying and Managing Bias in Artificial Intelligence (SP 1270) では、AI において、Systemic(既存のル一ルや規範、慣行等によるもの)、Statistical and Computational (統計的・計数的なもの)、Human(認知・知覚、習性等によるもの)とい う 3 つのかテゴリと、それぞれに属する典型的なバイアスがある旨が説明されている。\n\n* バイアスを生み出す要因は多岐に渡るため、各技術要素(学習データ、AIモデルの学習過程、AI 利用者又は業務外利用者が入力するプロンプト ${ }^{27}$ 、AIモデルの推論時に参照する情報、連携する外部サービス等)及びAI利用者の振る舞いを含めて、公平性の問題となりうる バイアスの要因となるポイントを特定する\n* AI システム・サービスの特性又は用途によっては、ステークホルダーが意図しない又は感知できな いバイアスが生じる可能性についても検討する\n\n\n(2) 人間の判断の介在 \n\n* AI の出力結果が公平性を欠くことがないよう、AIに単独で判断させるだけでなく、適切なタイミン グで人間の判断を介在させる利用を検討する。なおその際には、人間の判断が自動化バイアス に左右されないような対策 ${ }^{28}$ を講じるべきである\n* バイアスが生じていないか、AIシステム・サービスの目的、制約、要件及び決定を明確かつ透明性のある方法により分析し、対処するためのプロセスを導入する\n* ステークホルダーが意図しない又は感知できないバイアスや、潜在的なバイアス(学習データに は表れないバイアス) ${ }^{29}$ に留意し、多様な背景、文化又は分野のステークホルダーと対話した上で、方針を決定する\n"

},

{

"title": "4) プライバシー保護",

"node_id": "0018",

"page_index": 18,

"text": "#### 4) プライバシー保護\n\n各主体は、AIシステム・サービスの開発・提供・利用において、その重要性に応じ、プライバシーを尊重 し、保護することが重要である。その際、関係法令を遵守すべきである。\n(1) AIシステム・サービス全般におけるプライバシーの保護\n\n* 個人情報保護法 ${ }^{30}$ 等の関連法令の遵守、各主体のプライバシーポリシーの策定・公表等によ り、社会的文脈及び人々の合理的な期待を踏まえ、ステークホルダーのプライバシーが尊重さ れ、保護されるよう、その重要性に応じた対応を取る\n* 以下の事項を考慮しつつ、プライバシー保護のための対応策を検討する\n- 個人情報保護法にもとづいた対応の確保\n- 国際的な個人データ保護の原則及び基準の参照 ${ }^{31}$\n\n[^0]\n[^0]: ${ }^{27}$ 大規模言語モデルを始めとする生成AIでは、AI 利用者は、コンテキスト内学習と呼ばれる学習方法により、学習済パラメータを更新することな く、AI 利用者の入力(プロンプトと呼ばれる)に応じて、特定のタスクに対する学習を行わせることが可能である。\n ${ }^{28}$ 必要な対策については、前掲脚注 15 を参照。\n ${ }^{29}$ 潜在的なバイアスの例として、人種や性別等の明らかなセンシティブ属性を取り除いたデータであっても、関連する情報からセンシティブ属性が類推されてしまう場合や、複数の属性の組み合わせによってバイアスが生じてしまう場合(交差バイアス)などがある。\n ${ }^{30}$ 個人情報保護法については、個人情報保護委員会において、いわゆる 3 年ごと見直しに関する検討が進められている。その中で、AI 開発等を含む統計作成等のみを目的とした取り扱いを実施する場合の本人同意の在り方等が検討されている。\n https://www.ppc.go.jp/personalinfo/3nengotominaoshi/\n (2025 年 2 月公表資料 : https://www.ppc.go.jp/files/pdf/seidotekikadainitaisurukangaekatanitsuite_r6.pdf)\n ${ }^{31}$ OECD, Recommendation of the Council concerning Guidelines Governing the Protection of Privacy and Transborder Flows of Personal Data, OECD/LEGAL/0188, ISO/IEC 29100:2011 Information technology Security techniques Privacy framework 等プライ バシーに関する国際的な指針を踏まえることが期待される。また、より広範囲での個人データの円滑な越境移転及び各国における規律の相互運用性を促進させる等の目的で Global Cross-Border Privacy Rules (CBPR) Forum が立ち上がっており、日本も 2022 年 4 月に参加し、 Global CBPR Framework を公表している。また、生成AIに関しては、G7データ保護プライバシー機関ラウンドテーブル会合による「生成AIに関 する声明」(2023 年 6 月)及び GPA(Global Privacy Assembly)による「生成AIシステムに関する決議」(2023 年 10 月)も参照。\n"

},

{

"title": "5) セキュリティ確保",

"node_id": "0019",

"page_index": 19,

"text": "#### 5) セキュリティ確保\n\n各主体は、AIシステム・サービスの開発・提供・利用において、不正操作によってAIの振る舞いに意図 せぬ変更又は停止が生じることのないように、セキュリティを確保することが重要である。\n(1) AIシステム・サービスに影響するセキュリティ対策32\n$\\diamond$ AIシステム・サービスの機密性・完全性・可用性を維持し、常時、AIの安全安心な活用を確保するため、その時点での技術水準に照らして合理的な対策を講じる\n$\\diamond$ AIシステム・サービスの特性を理解し、正常な稼働に必要なシステム間の接続が適切に行われ ているかを検討する\n$\\diamond$ 推論対象データに微細な情報を混入させることで関連するステークホルダーの意図しない判断 が行われる可能性を踏まえて、AIシステム・サービスの脆弱性を完全に排除することはできない ことを認識する\n(2) 最新動向への留意\n$\\diamond$ AIシステム・サービスに対する外部からの攻撃は日々新たな手法が生まれており、これらのリスク に対応するための留意事項を確認する\n"

},

{

"title": "6) 透明性 ${ }^{33}$",

"node_id": "0020",

"page_index": 19,

"text": "#### 6) 透明性 ${ }^{33}$\n\n各主体は、AIシステム・サービスの開発・提供・利用において、AIシステム・サービスを活用する際の社会的文脈を踏まえ、AIシステム・サービスの検証可能性を確保しながら、必要かつ技術的に可能な範囲 で、ステークホルダーに対し合理的な範囲で情報を提供することが重要である。\n\n(1) 検証可能性の確保\n\n$\\diamond \\quad$ AI の判断にかかわる検証可能性を確保するため、データ量又はデータ内容に照らし合理的な範囲で、AIシステム・サービスの開発過程、利用時の入出力等、AIの学習プロセス、推論過程、判断根拠等のログを記録・保存する\n$\\diamond$ ログの記録・保存にあたつては、利用する技術の特性及び用途に照らして、事故等の原因究明、再発防止策の検討、損害賠償責任要件の立証上の重要性等を踏まえて、記録方法、\n\n[^0]\n[^0]: ${ }^{32}$ 詳細な手法については、英国サイバーセキュリティセンター(NCSC)「セキュアなAIシステム開発のためのガイドライン(Guidelines for secure AI system development)」(2023 年 11 月)が公開されている。\n https://www8.cao.go.jp/cstp/stmain/20231128ai.html\n ${ }^{33}$ 透明性については、諸外国でも様々な定義がある。例えば、NIST,Artificial Intelligence Risk Management Framework(January 2023)では、透明性(システムで何が起きたかについて答えられること)、説明可能性(システムでどのように決定がなされたかについて答えられる こと)及び解釈可能性(なぜその決定がされたかについてその意味又は文脈について答えられること)に分類されており、European Commission, ETHICS GUIDELINES FOR TRUSTWORTHY AI (April 2019)では、トレーサビリティ、説明可能性及びコミュニケーションが取り上げられている。また、国際標準(ISO/IEC JTC1/SC42)では、透明性(適切な情報が関係者に提供されること)と定義されている。その他に EU, AI 法(Artificial Intelligence Act)(June 2024)において透明性とは、AIシステムが適切な追跡可能性と説明可能性を実現する方法で開発及び利用され、人間がAIシステムで通信又は対話していることを認識できるようにし、AIシステムの機能と限界について利用者に適切に開示し、影響を受ける人間に対して権利について説明することを意味する。本文書では、情報開示に関する事項を広く透明性」とする。なお定義のほか、開示対象者や開示主体、開示目的が諸外国によって異なることにも留意する。\n\n頻度、保存期間等について検討する\n(2) 関連するステークホルダーへの情報提供\n\n* AI との関係の仕方、AIの性質、目的等に照らして、それぞれが有する知識及び能力に応じ、例えば、以下について取りまとめた情報の提供及び説明を行う\n* AI システム・サービス全般\n$>$ AI を利用しているという事実及び活用している範囲\n$>$ データ収集及びアノテーションの手法\n$>$ 学習及び評価の手法\n$>$ 基盤としているAIモデルに関する情報\n$>$ AI システム・サービスの能力、限界及び提供先における適正/不適正な利用方法\n$>$ AI システム・サービスの提供先、AI 利用者が所在する国・地域等において適用され る関連法令等\n* 多様なステークホルダーとの対話を通じて積極的な関与を促し、社会的な影響及び安全性に関する様々な意見を収集する\n* 加えて、実態に即して、AIシステム・サービスを提供・利用することの優位性、それに伴うリスク等 を関連するステークホルダーに示す\n(3) 合理的かつ誠実な対応\n* 上記の「(2)関連するステークホルダーへの情報提供」は、アルゴリズム又はソースコードの開示を必ずしも想定するものではなく、プライバシー及び営業秘密を尊重して、採用する技術の特性 及び用途に照らし、社会的合理性が認められる範囲で実施する(ただし、後掲する「(4)関連 するステークホルダーへの説明可能性・解釈可能性の向上」や『7)アカウンタビリティ』の要請 を満たす必要がある)\n* 公開されている技術を用いる際には、それぞれ定められている規程に準拠する\n* 開発したAIシステムのオープンソース化にあたっても、社会的な影響を検討する\n(4) 関連するステークホルダーへの説明可能性・解釈可能性の向上\n* 関連するステークホルダーの納得感及び安心感の獲得、また、そのためのAIの動作に対する証拠の提示等を目的として、説明する主体がどのような説明が求められるかを分析・把握できるよ う、説明を受ける主体がどのような説明が必要かを共有し、必要な対応を講じる\n* AI 提供者:AI 開発者に、どのような説明が必要となるかを共有する\n* AI 利用者:AI 開発者・AI 提供者に、どのような説明が必要となるかを共有する\n"

},

{

"title": "7) アカウンタビリティ ${ }^{34}$",

"node_id": "0021",

"page_index": 20,

"text": "#### 7) アカウンタビリティ ${ }^{34}$\n\n各主体は、AIシステム・サービスの開発・提供・利用において、トレーサビリティの確保、「共通の指針」の対応状況等について、ステークホルダーに対して、各主体の役割及び開発・提供・利用するAIシステム・サ\n\n[^0]\n[^0]: ${ }^{34}$ アカウンタビリティを説明可能性と定義することもあるが、本ガイドラインでは情報開示は透明性で対応することとし、アカウンタビリティとはAIに関 する事実上・法律上の責任を負うこと及びその責任を負うための前提条件の整備に関する概念とする。\n\n一ビスのもたらすリスクの程度を踏まえ、合理的な範囲でアカウンタビリティを果たすことが重要である。\n\n(1) トレーサビリティの向上 \n\n$\\diamond$ データの出所、AIシステム・サービスの開発・提供・利用中に行われた意思決定等について、技術的に可能かつ合理的な範囲で追跡・遡求が可能な状態を確保する\n\n(2) 「共通の指針」の対応状況の説明\n\n$\\diamond$ 「共通の指針」の対応状況について、ステークホルダー(サプライヤーを含む)に対してそれぞれ が有する知識及び能力に応じ、例えば以下の事項を取りまとめた情報の提供及び説明を定期的に行う\n\n・全般\n> 「共通の指針」の実践を妨げるリスクの有無及び程度に関する評価\n> 「共通の指針」の実践の進捗状況\n- 「人間中心」関連\n> 偽情報等への留意、多様性・包摂性、利用者支援及び持続可能性の確保の対応状況\n- 「安全性」関連\n> AI システム・サービスに関する既知のリスク及び対応策、並びに安全性確保の仕組 み\n- 「公平性」関連\n> AI モデルを構成する各技術要素(学習データ、AIモデルの学習過程、AI 利用者 又は業務外利用者が入力すると想定するプロンプト、AIモデルの推論時に参照する情報、連携する外部サービス等)によってバイアスが含まれうること\n- 「プライバシー保護」関連\n> AI システム・サービスにより自己又はステークホルダーのプライバシーが侵害されるリス ク及び対応策、並びにプライバシー侵害が発生した場合に講ずることが期待される措置\n- 「セキュリティ確保」関連\n> AI システム・サービスの相互間連携又は他システムとの連携が発生する場合、その促進のために必要な標準準拠等\n> AI システム・サービスがインターネットを通じて他のAIシステム・サービス等と連携する場合に発生しうるリスク及びその対応策\n\n3 責任者の明示\n$\\diamond$ 各主体においてアカウンタビリティを果たす責任者を設定する\n(4) 関係者間の責任の分配\n$\\diamond$ 関係者間の責任について、業務外利用者も含めた主体間の契約、社会的な約束(ボランタリ一コミットメント)等により、責任の所在を明確化する\n(5) ステークホルダーへの具体的な対応\n\n必要に応じ、AI システム・サービスの利用に伴うリスク管理、安全性確保のための各主体のAI ガバナンスに関するポリシー、プライバシーポリシー等の方針を策定し、公表する(社会及び一般市民に対するビジョンの共有、並びに情報発信・提供を行うといった社会的責任を含む)\n必要に応じ、AIの出力の誤り等について、ステークホルダーからの指摘を受け付ける機会を設け るとともに、定期的かつ客観的なモニタリングを実施する\nステークホルダーの利益を損なう事態が生じた場合 ${ }^{35}$ 、どのように対応するか方針を策定してこれ を着実に実施し、進捗状況については必要に応じて定期的にステークホルダーに報告する\n(6) 文書化 ${ }^{36}$\n上記に関する情報を文書化して一定期間保管し、必要なときに、必要なところで、入手可能 かつ利用に適した形で参照可能な状態とする\n\n各主体が社会と連携して取り組むことが期待される事項は、具体的には、下記のとおり整理される。\n"

},

{

"title": "8) 教育・リテラシー",

"node_id": "0022",

"page_index": 22,

"text": "#### 8) 教育・リテラシー\n\n各主体は、主体内のAIに関わる者が、AIの正しい理解及び社会的に正しい利用ができる知識・リテラ シー・倫理感を持つために、必要な教育を行うことが期待される。また、各主体は、AIの複雑性、誤情報と いった特性及び意図的な悪用の可能性もあることを勘案して、ステークホルダーに対しても教育を行うこと が期待される。37\n\n(1) AIリテラシーの確保\n\n各主体内のAIに関わる者が、その関わりにおいて十分なレベルのAIリテラシーを確保するため に必要な措置を講じる\n\n(2) 教育・リスキリング\n\n[^0]\n[^0]: ${ }^{35}$ 特に、学習データ等の権利者やAIの評価、判断、奨励、又は予測等によって不利益を被った者等から問合せや情報開示の要望を受けた場合には、必要な範囲で適切な対応を行うことが望ましい。また、裁判所からの開示命令等があった場合には、当該命令等に従って必要な手続き を取ることが求められる。\n ${ }^{36}$ 「文書化」については、後から容易に確認可能となるよう適切なツールで記録が残されていれば差し支えなく、必ずしも紙媒体や特定の文書の形式による必要はない。\n ${ }^{37}$ 経済産業省・IPAは、個人の学習及び企業の人材確保・育成の指針としてDX時代の人材像を「デジタルスキル標準」として整理(2022年 12 月)。2023年8月に「生成AI時代のDX推進に必要な人材・スキルの考え方」を取りまとめ、指示(プロンプト)の習熟、「問いを立てる」「仮説検証する」等の必要性をスキル標準に反映し、2024年7月には、普及する生成AIの影響を踏まえ、新技術への向き合い方等を補足とし て追加し、「データ活用」「テクノロジー」の学習項目例に「大規模言語モデル・画像生成モデル・オーディオ生成モデル」等の生成AI関連の技術を追加。また、経済産業省は、知的財産権等の権利・利益の保護に十分に配慮した、コンテンツ制作における生成AIの適切な利活用の方向性 を示す「コンテンツ制作のための生成AI利活用ガイドブック」を公表(2024年7月)。\n https://www.meti.go.jp/policy/mono_info_service/contents/ai_guidebook_set.pdf\n ・デジタルスキル標準 https://www.meti.go.jp/policy/it_policy/jinzaI/skill_standard/main.html\n ・デジタル時代の人材政策に関する検討会 https://www.meti.go.jp/shingikaI/mono_info_service/digital_jinzaI/index.html また、総務省は今後の生活の中で生成AIに触れうる国民(初心者)向けに、生成AIの基礎知識、生成AIの活用場面や入門的な使い方、生成AI活用時の注意点などを紹介する「生成AIはじめの一歩~生成AIの入門的な使い方と注意点~」を公表。\n https://www.soumu.go.jp/use_the_internet_wisely/special/generativeai/\n\n* 生成AIの活用拡大によって、AI と人間の作業の棲み分けが変わっていくと想定されるため、新 たな働き方ができるよう教育・リスキリング等を検討する ${ }^{38}$\n*様々な人がAI で得られる便益の理解を深め、リスクに対するレジリエンスを高められるよう、世代間ギヤップも考慮した上での教育の機会を提供する\n(3) ステークホルダーへのフォローアップ\n* AI システム・サービス全体の安全性を高めるため、必要に応じて、ステークホルダーに対して教育及びリテラシー向上のためのフォローアップを行う\n"

},

{

"title": "9) 公正競争確保",

"node_id": "0023",

"page_index": 23,

"text": "#### 9) 公正競争確保\n\n各主体は、AIを活用した新たなビジネス・サービスが創出され、持続的な経済成長の維持及び社会課題の解決策の提示がなされるよう、AIをめぐる公正な競争環境の維持に努めることが期待される。\n"

},

{

"title": "10) イノベーション",

"node_id": "0024",

"page_index": 23,

"text": "#### 10) イノベーション\n\n各主体は、社会全体のイノベーションの促進に貢献するよう努めることが期待される。\n(1) オープンイノベーション等の推進\n\n* 国際化・多様化、産学官連携及びオープンイノベーションを推進する\n* AI のイノベーションに必要なデータが創出される環境の維持に配慮する\n(2) 相互接続性・相互運用性への留意\n* 自らのAIシステム・サービスと他のAIシステム・サービスとの相互接続性及び相互運用性を確保する\n* 標準仕様がある場合には、それに準拠する\n(3) 適切な情報提供\n* 自らのイノベーションを損なわない範囲で必要な情報提供を行う\n\n以上の事項に加え、AI 開発者、AI 提供者又はAI 利用者のそれぞれで重要となる事項は、「表 1. 共通の指針に加えて主体毎に重要となる事項」のとおり整理される。なお、表の「-」が記載されている箇所は、各主体 による第 2 部 C、「共通の指針」記載の事項にもとづく対応が期待されており、対応不要を意味するものではな い。\n\nなお、特にAI と知的財産権との関係については、AI 開発者、AI 提供者又はAI 利用者の各主体に期待さ れる取組につき、内閣府「AI 時代の知的財産権検討会 中間とりまとめ」(2024年5月)や文化庁著作権課「AI と著作権に関するチェックリスト&ガイダンス」(2024年7月)において整理されている。各主体において は、その趣旨を踏まえた対応方針を検討することが重要となる。\n\n[^0]\n[^0]: ${ }^{38}$ 厚生労働省の雇用政策研究会にて「新たなテクノロジー等を活用した労働生産性の向上」というテーマで、技術変化を踏まえたキヤリア形成や スキル教育について触れられている。\n https://www.mhlw.go.jp/stf/shingi/other-syokuan_128950.html\n\n以降は「表 1.「共通の指針」に加えて主体毎に重要となる事項」に記載されている内容(項目)を. [主体 - 指針番号)記載内容. ]のルールにて識別・表記する。\n\n・主体は、AI 開発者(AI $\\underline{\\underline{D}}$ eveloper)、AI 提供者(AI $\\underline{\\underline{P r v v i d e r}}$ )及びAI 利用者(AI Business User)の頭文字を用い、指針番号及び記載内容の番号は同表に記載の番号にて表記する\n\n例)D-2)I. はAI 開発者の安全性に関する適切なデータの学習についての重要事項を指す\n\n表 1.「共通の指針」に加えて主体毎に重要となる事項\n\n| | 第2部。 <br> C.共通の指針 | 「共通の指針」に加えて主体毎に重要となる事項 | | |\n| --- | --- | --- | --- | --- |\n| | | 第3部。AI開発者\n(D) | 第4部。AI提供者\n(P) | 第5部。AI利用者\n(11) |\n| 1)\n人間中心 | (1) 人間の尊厳及び個人の自律\n(2) AI による意思決定・感情の操作等への留意\n(3) 価情報等への対策\n(4) 多様性・包摂性の確保\n(5) 利用者支援\n(6) 持続可能性の確保 | ・ | ・ | ・ |\n| 2)\n安全性 | (1) 人間の生命・身体・財産、精神及び環境への配慮\n(2) 適正利用\n(3) 適正学習 | i. 適切なデータの学習\nii. 人間の生命・身体・財産、精神及び環境に配慮した開発\niii. 適正利用に資する開発 | i. 人間の生命・身体・財産、精神\n及び環境に配慮したリスク対策\nii. 適正利用に資する提供 | i. 安全を考慮した適正利用 |\n| 3)\n公平性 | (1) AIモデルの各構成技術に\n含まれるバイアスへの配慮\n(2) 人間の判断の介在 | i. データに含まれるバイアスへの配慮\nii. AIモデルのアルゴリズム等に含まれるバイアスへの配慮 | i. AI システム・サービスの構成及び データに含まれるバイアスへの配慮 | i. 入力データ又はプロンプトに含まれるバイアスへの配慮 |\n| 4)\nプライバシー\n保護 | (1) AIシステム・サービス全般にお けるプライバシーの保護 | i. 適切なデータの学習\n(D-2) i. 再掲) | i. プライバシー保護のための仕組み及び対策の導入\nii. プライバシー侵害への対策 | i. 個人情報の不適切入力及び プライバシー侵害への対策 |\n| 5)\nセキュリティ\n確保 | (1) AIシステム・サービスに影響す るセキュリティ対策\n(2) 最新動向への留意 | i.セキュリティ対策のための仕組み の導入\nii. 最新動向への留意 | i.セキュリティ対策のための仕組み の導入\nii. 脆弱性への対応 | i.セキュリティ対策の実施 |\n| 6)\n透明性 | (1) 検証可能性の確保\n(2) 関連するステークホルダーへの情報提供\n(3) 合理的かつ誠実な対応\n(4) 関連するステークホルダーへの説明可能性・解釈可能性の向上 | i. 検証可能性の確保\nii. 関連するステークホルダーへの情報提供 | i. システムアーキテクチャ等の\n文書化\nii. 関連するステークホルダーへの情報提供 | i. 関連するステークホルダーへの情報提供 |\n| 7)\nアカウンタ\nピリティ | (1) トレーサピリティの向上\n(2) 「共通の指針」の対応状況の説明\n(3) 責任者の明示\n(4) 関係者間の責任の分配\n(5) ステークホルダーへの具体的 な対応\n(6) 文書化 | i. AI 提供者への「共通の指針」の対応状況の説明\nii. 開発関連情報の文書化 | i. AI 利用者への「共通の指針」の対応状況の説明\nii. サービス規約等の文書化 | i. 関連するステークホルダーへの説明\nii. 提供された文書の活用及び規約の遵守 |\n| 8)\n教育・\nリテラシー | (1) AIリテラシーの確保\n(2) 教育・リスキリング\n(3) ステークホルダーへの フォローアップ | ・ | ・ | ・ |\n| 9)\n公正競争確保 | ・ | ・ | ・ | ・ |\n| 10)\nイノベーション | (1) オープンイノベーション等の推進\n(2) 相互接続性・相互運用性へ の留意\n(3) 適切な情報提供 | i.イノベーションの機会創造への貢献 | ・ | ・ |\n"

},

{

"title": "D. 高度な AI システムに関係する事業者に共通の指針",

"node_id": "0025",

"page_index": 26,

"text": "#### D. 高度な AI システムに関係する事業者に共通の指針\n\n高度な AI システムに関係する事業者は、広島 AI プロセスを経て策定された「全てのAI 関係者向けの広島 プロセス国際指針」及びその基礎となる「高度な AI システムを開発する組織向けの広島プロセス国際指針」を踏まえ、「共通の指針」に加え、以下を遵守すべきである ${ }^{39}$ 。ただし、I)〜XI)は高度なAIシステムを開発する AI 開発者にのみ適用される内容もあるため、第 $3 \\sim 5$ 部に後述のとおり、AI 提供者及び AI 利用者は適切な範囲で遵守することが求められる。\nI) AI ライフサイクル全体にわたるリスクを特定、評価、軽減するために、高度なAIシステムの開発全体を通じ て、その導入前及び市場投入前も含め、適切な措置を講じる(「2)安全性」、「6)透明性」「7)アカ ウンタビリティJ)\n$>$ 具体的には、レッドチーム ${ }^{40}$ 等の様々な手法を組み合わせて、多様/独立した内外部テスト手段を採用することや、特定されたリスクや脆弱性に対処するための適切な緩和策を実施する\n$>$ 上記テストを支援するために、開発中に行われた意思決定に関するトレーサビリティを確保するように努める\nII) 市場投入を含む導入後、脆弱性、及び必要に応じて悪用されたインシデントやパターンを特定し、緩和す る(「5)セキュリティ確保」、「7)アカウンタビリティ」)\n$>$ リスクレベルに見合った適切なタイミングで、AI システムの活用状況のモニタリングを実施し、それらに対処するための適切な措置を講じる\n$\\diamond$ 他の利害関係者と協力して、報告されたインシデントの適切な文書化を維持し、特定されたリ スクと脆弱性を軽減することが奨励される\nIII) 高度な AI システムの能力、限界、適切・不適切な使用領域を公表し、十分な透明性の確保を支援する ことで、アカウンタビリティの向上に貢献する(「6)透明性」、「7)アカウンタビリティ」)\n$>$ データの出所に始まり、どのような意思決定を行つたかについて、合理的な説明を行い、トレーサビリテ イを確保するため文書化・公表する\n$>$ 関連するステークホルダーがAIシステムの出力を解釈し、AI 利用者や業務外利用者が適切に活用 できるようにするために、明確で理解可能な形で文書化・公表する\nIV) 産業界、政府、市民社会、学界を含む、高度なAIシステムを開発する組織間での責任ある情報共有 とインシデントの報告に向けて取り組む(「5)セキュリティ確保」、「6)透明性」、「7)アカウンタビリテ イ」、「10)イノベーション」)\n\n[^0]\n[^0]: ${ }^{39}$ 詳細は、G7 デジタル・技術大臣会合(2023 年 12 月)で採択された「広島 AI プロセス G7 デジタル・技術閣僚声明」における「広島 AI プロセ ス包括的政策枠組み」の「II、全てのAI 関係者向け及び高度なAIシステムを開発する組織向けの広島プロセス国際指針」を参照。 https://www.soumu.go.jp/menu_news/s-news/01tsushin06_02000283.html\n ${ }^{40}$ 攻撃者がどのように対象組織を攻撃するかの観点で、セキュリティへの対応体制及び対策の有効性を確認するチームを意味する。なお、AISI か らレッドチーミング手法ガイドが公表されている。\n AISI「AI セーフティに関するレッドチーミング手法ガイド」(2024 年 9 月)\n https://aisi.go.jp/effort/effort_framework/guide_to_red_teaming_methodology_on_ai_safety/\n\n> 具体的には、モニタリング結果の報告書やセキュリティや安全性のリスクに関する関連文書等が含ま れる\nV) 特に高度な AI システム開発者に向けた、個人情報保護方針及び緩和策を含む、リスクベースのアプロー チにもとづくAIガバナンス及びリスク管理方針を策定し、実施し、開示する(「4)プライバシー保護」、「7)アカウンタビリティ」)\n> 適切な場合には、プライバシーボリシーを公表する\n> AIガバナンスに関するボリシーや実行するための組織を確立し、開示することが期待される\nVI) AI のライフサイクル全体にわたり、物理的セキュリティ、サイバーセキュリティ、内部脅威に対する安全対策を含む、強固なセキュリティ管理に投資し、実施する(「5)セキュリティ確保」)\n> 情報セキュリティのための運用上の対策や適切なサイバー/物理的アクセス制御等も検討する\nVII)技術的に可能な場合は、電子透かしやその他の技術等、AI 利用者及び業務外利用者が、AI が生成し たコンテンツを識別できるようにするための、信頼できるコンテンツ認証及び来歴のメカニズムを開発し、導入 する(「6)透明性」)\n> 具体的には、適切かつ技術的に実現可能な場合、組織の高度なAIシステムで作成されたコンテン ツ認証及び来歴メカニズムが含まれる\n> 透かし等を通じた特定のコンテンツが高度なAIシステムで作成されたかどうかをAI利用者及び業務外利用者が判断できるツールや API の開発に努める\n$\\diamond \\mathrm{AI}$ 利用者及び業務外利用者がAIシステムと相互作用していることを知ることができるよう、ラベ リングや免責事項の表示等、その他の仕組みを導入することが奨励される\nVIII) 社会的、安全、セキュリティ上のリスクを軽減するための研究を優先し、効果的な軽減策への投資を優先 する(「10)イノベーション」)\n> AI の安全性、セキュリティ、信頼性の向上やリスクへの対処に関する研究が含まれる\nIX) 世界の最大の課題、特に気候危機、世界保健、教育等(ただしこれらに限定されない)に対処するた め、高度なAIシステムの開発を優先する(「10)イノベーション」)\n> 信頼性のある人間中心のAI 開発に向けた取組を実施し、同時に業務外利用者も含めたリテラシー の向上のための支援をする\nX) 国際的な技術規格の開発を推進し、適切な場合にはその採用を推進する(「10)イノベーション」)\n> 電子透かしを含む国際的な技術標準とベストプラクティスの開発に貢献し、適切な場合にはそれを利用し、標準開発組織(SDO)と協力する\nXI) 適切なデータインプット対策を実施し、個人データ及び知的財産を保護する(「2)安全性」、「3)公平性」)\n> 有害な偏見バイアスを軽減するために、訓練データやデータ収集等、データの質を管理するための適切な措置を講じることが奨励される\n> 訓練用データセットの適切な透明性も支援されるべきであり、適用される法的枠組みを遵守する\n\nXII)高度なAIシステムの信頼でき責任ある利用を促進し、貢献する(「5)セキュリティ確保」、「8)教育・ リテラシー」)\n$>$ 高度なAIシステムが特定のリスク(例えば偽情報の拡散に関するもの)をどのように増大させるか、新たなリスクをどのように生み出すか等の課題を含め、各主体及びステークホルダーのリテラシーや認識等の向上のための機会を提供する\n$>$ 各主体間で連携し、高度なAIシステムに関する新たなリスクや脆弱性を特定し、対処するための情報共有を行うことが奨励される\n"

},

{

"title": "E. AI ガバナンスの構築",

"node_id": "0026",

"page_index": 28,

"text": "#### E. AI ガバナンスの構築\n\n各主体間で連携しバリューチェーン全体で「共通の指針」を実践しAIを安全安心に活用していくためには、AI に関するリスクをステークホルダーにとって受容可能な水準で管理しつつ、そこからもたらされる便益を最大化する ための、AI ガバナンスの構築が重要となる。また、「Society 5.0」を実現するためには、サイバー空間とフィジカル空間を高度に融合させたシステム(CPS)の社会実装を進めつつ、その適切なAI ガバナンスを構築することが不可欠である。CPSを基盤とする社会は、複雑で変化が速く、リスクの統制が困難であり、こうした社会の変化 に応じて、AI ガバナンスが目指すゴールも常に変化していく。そのため、事前にルール又は手続が固定されたAI ガバナンスではなく、企業・法規制・インフラ・市場・社会規範といった様々なガバナンスシステムにおいて、「環境・リスク分析」「ゴール設定」「システムデザイン」「運用」「評価」といったサイクルを、マルチステークホルダーで継続的かつ高速に回転させていく、「アジャイル・ガバナンス」の実践が重要となる ${ }^{41}$ 。\n\nなお、具体的な検討にあたつては開発・提供・利用予定のAIのもたらすリスクの程度及び蓋然性、並びに各主体の資源制約に配慮することが重要である。\n(1) まず、AIシステム・サービスがライフサイクル全体においてもたらしうる便益/リスク、開発・運用に関する社会的受容、「外部環境の変化」、AI 習熟度等を踏まえ、対象となるAIシステム・サービスに関連 する「環境・リスク分析」を実施する\n(2) これを踏まえ、AIシステム・サービスを開発・提供・利用するか否かを判断し、開発・提供・利用する場合には、AI ガバナンスに関するポリシーの策定等を通じて「AI ガバナンス・ゴール42の設定」を検討す る。なお、このAI ガバナンス・ゴールは、各主体の存在意義、理念・ビジョンといった経営上のゴールと整合したものとなるように設定する\n\n[^0]\n[^0]: ${ }^{41}$ 別添(付属資料)において、経済産業省「AI 原則実践のためのガバナンス・ガイドライン Ver. 1.1」を土台とした、AI ガバナンス実践のための詳細解説に加え、各主体の具体的な取組事項としての「行動目標」及び各主体を想定した仮想的な「実践例」も記載しているため、ご参照のこ と。\n ${ }^{42}$ AI ガバナンス・ゴールとして、本ガイドラインに記載の「共通の指針」への対応事項からなる自社の取組方針(「AI ポリシー」等、呼称は各主体に より相違)及び「共通の指針」への対応事項を包含しつつそれ以外の要素を含む取組方針(データ活用ポリシー等)を設定すること等が考えら れる。AIを活用することによって多様性・包摂性を向上させる等の便益を高めるための指針を提示してもよい。また、呼称も各主体に委ねられてい る。\n\n(3) 更に、このAIガバナンス・ゴールを達成するための「AIマネジメントシステムの設計」を行った上で、これ を「運用」する。その際には、各主体が、AI ガバナンス・ゴール及びその運用状況について外部の「ステ ークホルダーに対する透明性、アカウンタビリティ(公平性等)」を果たすようにする\n(4) その上で、リスクアセスメント等をはじめとして、AI マネジメントシステムが有効に機能しているかを継続的にモニタリングし、「評価」及び継続的改善を実施する\n(5) AI システム・サービスの運用開始後も、規制等の社会的制度の変更等の「外部環境の変化」を踏ま え、再び「環境・リスク分析」を実施し、必要に応じてゴールを見直す\n\n\n図6.アジャイル・ガバナンスの基本的なモデル\n\nまた、AI ガバナンスの検討にあたつては、バリューチェーンを念頭に置き、以下の点に留意することが重要であ る。\n> バリューチェーン/リスクチェーンの観点で主体間の連携を確保する\n$\\diamond$ 複数主体にまたがる論点の例:AIリスク把握、品質の向上、各AIシステム・サービスが相互に繋がること(System of Systems)による新たな価値の創出、AI 利用者又は業務外利用者 のリテラシー向上等\n$\\diamond$ 主体間で整理が必要になりうる点の例:学習及び利用に用いるデータ・生成されたAIモデル に関する権利関係の契約等\n> データの流通をはじめとしたリスクチェーンの明確化、並びに開発・提供・利用の各段階に適したリスク管理及びAI ガバナンス体制の構築を実施する\n$\\diamond$ AI 開発からサービス実施にわたるバリューチェーン/リスクチェーンが複数国にまたがることが想定さ れる場合、データの自由な流通(Data Free Flow with Trust、以下、「DFFT」という)の確保のための適切なAI ガバナンスに係る国際社会の検討状況の把握及びそれを踏まえた相互運用性の確保(「標準」及び「枠組み間の相互運用性」の二側面)\n\nこれらを効果的な取組とするためには、経営層の責任は大きく、そのため、リーダーシップを発揮することが重要 である。その際は、短期的な利益の追求の観点からAI ガバナンスの構築を単なるコストと捉えるのではなく、各\n\n主体の持続的成長及び中長期的な発展を志向した先行投資として捉えることが重要である。そのリーダーシッ プの下、上記のアジャイル・ガバナンスのサイクルを回しつつ、各組織の戦略及び企業体制にAIガバナンスを落と し込んでいくことで、各組織の中で文化として根付かせることが期待される。\n"

}

]

},

{

"title": "第3部 AI 開発者に関する事項",

"node_id": "0027",

"page_index": 31,

"text": "### 第3部 AI 開発者に関する事項\n\nAI 開発者は、AIモデルを直接的に設計し変更を加えることができるため、AIシステム・サービス全体において もAIの出力に与える影響力が高い。また、イノベーションを牽引することが社会から期待され、社会全体に与え る影響が非常に大きい。このため、自身の開発するAIが提供・利用された際にどのような影響を与えるか、事前 に可能な限り検討し、対応策を講じておくことが重要となる。\n\nAI 開発の現場においては、時に、正確性を重視するためにプライバシー又は公平性が損なわれたり、プライバ シーを過度に重視して透明性が損なわれたり等、リスク同士又は倫理観の衝突の場面がある。その場合、当該事業者における経営リスク及び社会的な影響力を踏まえ、適宜判断・修正していくことが重要である。また、AI システムにおいて予期せぬ事故が発生した際に、AIのバリューチェーンに連なる者は、何らかの説明を求められる立場に立つ可能性があることを念頭に置き、AI 開発者としても、どのような関与を行ったかについて、合理的な説明を行うことができるよう記録を残すことが重要である ${ }^{43}$ 。\n\n以下にAI 開発者にとって重要な事項を挙げる。\n\n- データ前処理・学習時\n\n$>$ D-2) i. 適切なデータの学習\n$\\diamond$ プライバシー・バイ・デザイン等を通じて、学習時のデータについて、適正に収集するとともに、第三者の個人情報、知的財産権に留意が必要なもの等が含まれている場合には、法令に従って適切に扱うことを、AIのライフサイクル全体を通じて確保する(「2)安全性」、「4)プライバシ一保護」、「5)セキュリティ確保」)\n$\\diamond$ 学習前・学習全体を通じて、データのアクセスを管理するデータ管理・制限機能の導入検討を行う等、適切な保護措置を実施する(「2)安全性」、「5)セキュリティ確保」)\n$>$ D-3) i. データに含まれるバイアスへの配慮\n$\\diamond$ 学習データ、AIモデルの学習過程によってバイアス(学習データには現れない潜在的なバイアス を含む)が含まれうることに留意し、データの質を管理するための相当の措置を講じる(「3)公平性」)\n$\\diamond$ 学習データ、AIモデルの学習過程からバイアスを完全に排除できないことを踏まえ、AIモデルが代表的なデータセットで学習され、AIシステムに不公正なバイアス(特定の個人・集団に対し、合理的に説明できない不利益をもたらすバイアス)がないか点検されることを確保する(「3)公平性」)\n",

"nodes": [

{

"title": "- AI 開発時",

"node_id": "0028",

"page_index": 31,

"text": "#### - AI 開発時\n\n$>$ D-2) ii. 人間の生命・身体・財産、精神及び環境に配慮した開発\n\n[^0]\n[^0]: ${ }^{43}$ AI の開発等にあたり、AIの信頼性を向上させるためのツールや指標のカタログが、OECD により提供されている。 https://oecd.ai/en/catalogue/overview\n\n> ステークホルダーの生命・身体・財産、精神及び環境に危害を及ぼすことがないよう、以下の事項を検討する(「2)安全性」)\n> - 様々な状況下で予想される利用条件下でのパフォーマンスだけでなく、予期しない環境での利用にも耐えうる性能の要求\n> - リスク(連動するロボットの制御不能、不適切な出力等)を最小限に抑える方法の要求(ガードレール技術等)\n> D-2)iii. 適正利用に資する開発\n> 開発時に想定していない AI の提供・利用により危害が発生することを避けるため、安全に利用可能な AI の使い方について明確な方針・ガイダンスを設定する(「2)安全性」)\n> 事前学習済の AI モデルに対する事後学習を行う場合に、学習済 AI モデルを適切に選択する(商用利用可能なライセンスかどうか、事前学習データ、学習・実行に必要なスペック等)(「2)安全性」)\n> D-3)ii. AI モデルのアルゴリズム等に含まれるバイアスへの配慮\n> AI モデルを構成する各技術要素(AI 利用者又は業務外利用者が入力するプロンプト、AI モデルの推論時に参照する情報、連携する外部サービス等)によってバイアスが含まれうることまで検討する(「3)公平性」)\n> AI モデルからバイアスを完全に排除できないことを踏まえ、AI モデルが代表的なデータセットで学習され、AI システムに不公正なバイアスがないか点検されることを確保する(「3)公平性」)\n> D-5)i. セキュリティ対策のための仕組みの導入\n> AI システムの開発の過程を通じて、採用する技術の特性に照らし適切にセキュリティ対策を講ずる(セキュリティ・バイ・デザイン)(「5)セキュリティ確保」)\n> D-6)i. 検証可能性の確保\n> AI の予測性能及び出力の品質が、活用開始後に大きく変動する可能性又は想定する精度に達しないこともある特性を踏まえ、事後検証のための作業記録を保存しつつ、その品質の維持・向上を行う(「2)安全性」、「6)透明性」)\n\n- > AI 開発後\n> D-5)ii. 最新動向への留意\n> AI システムに対する攻撃手法は日々新たなものが生まれており、これらのリスクに対応するため、開発の各工程で留意すべき点を確認する44(「5)セキュリティ確保」)\n> D-6)ii. 関連するステークホルダーへの情報提供\n\n> ^{44} IPA「AI(Artificial Intelligence)の推進」(https://www.ipa.go.jp/digital/ai/index.html)等を通じて情報を収集することができる。\n\n> 自らの開発するAIシステムについて、例えば以下の事項を適時かつ適切に関連するステークホルダーに(AI 提供者を通じて行う場合を含む)情報を提供する(「6)透明性」)\n\n- AI システムの学習等による出力又はプログラムの変化の可能性(「1)人間中心」)\n- AI システムの技術的特性、安全性確保の仕組み、利用の結果生じる可能性のある予見可能なリスク及びその緩和策等の安全性に関する情報(「2)安全性」)\n- 開発時に想定していないAIの提供・利用により危害が発生することを避けるためのAI開発者が意図する利用範囲(「2)安全性」)\n- AI システムの動作状況に関する情報並びに不具合の原因及び対応状況(「2)安全性」)\n- AI の更新を行った場合の内容及びその理由の情報(「2)安全性」)\n- AI モデルで学習するデータの収集ポリシー、学習方法及び実施体制等(「3)公平性」、「4)プライバシー保護」、「5)セキュリティ確保」)\n\nD-7) i. AI 提供者への「共通の指針」の対応状況の説明\n\n> AI 提供者に対して、AIには活用開始後に予測性能又は出力の品質が大きく変動する可能性、想定する精度に達しないこともある旨、その結果生じうるリスク等の情報提供及び説明を行う。具体的には以下の事項を周知する(「7)アカウンタビリティ」)\n> AI モデルを構成する各技術要素(学習データ、AIモデルの学習過程、AI利用者又は業務外利用者が入力すると想定するプロンプト、AIモデルの推論時に参照する情報、連携する外部サービス等)において含まれる可能性があるバイアスへの対応等(「3)公平性」)\n\nD-7) ii. 開発関連情報の文書化\n\n> トレーサビリティ及び透明性の向上のため、AIシステムの開発過程、意思決定に影響を与えるデータ収集及びラベリング、使用されたアルゴリズム等について、可能な限り第三者が検証できるような形で文書化する(「7)アカウンタビリティ」)\n(注)ここで文書化されたものをすべて開示するという意味ではない\n\n以下に、AI 開発者の取組が期待される事項を挙げる。\n\nD-10) i. イノベーションの機会創造への貢献\n\n> 可能な範囲で以下の事項を実施し、イノベーションの機会の創造に貢献することが期待される(「10)イノベーション」)\n> AI の品質・信頼性、開発の方法論等の研究開発を行う\n> 持続的な経済成長の維持及び社会課題の解決策が提示されるよう貢献する\n> DFFT 等の国際議論の動向の参照、AI 開発者コミュニティ又は学会への参加の取組等、国際化・多様化及び産学官連携を推進する\n> 社会全体へのAIに関する情報提供を行う\n\n##### 「高度な AI システムを開発する組織向けの広島プロセス国際行動規範」における追加的な記載事項\n\n高度な AI システムを開発する AI 開発者については、上記に加え、「第 2 部 D. 高度な AI システムに関係す る事業者に共通の指針」及び「高度な AI システムを開発する組織向けの広島プロセス国際行動規範」45を遵守すべきである。\n\n以下、「第 2 部 D. 高度な AI システムに関係する事業者に共通の指針」との比較において、当該「行動規範」において追加的に記載されている事項を示す。なお、当該「行動規範」全体の内容については、「別添 3. C. 高度な AI システムの開発にあたって遵守すべき事項」を参照のこと。\nI. AI ライフサイクル全体にわたるリスクを特定、評価、軽減するために、高度な AI システムの開発全体を通じ て、その導入前及び市場投入前も含め、適切な措置を講じる\n> リスク軽減のための緩和策を文書化するとともに、定期的に更新すべき。また、各主体はセクターを超 えた関係者と連携してこれらのリスクへの緩和策を評価し、採用すべき\nII. 市場投入を含む導入後、脆弱性、及び必要に応じて悪用されたインシデントやパターンを特定し、緩和す る\n> 報奨金制度、コンテスト、賞品等を通じて、責任を持って弱点を開示するインセンティブを与えること の検討を奨励\nIII. 高度な AI システムの能力、限界、適切・不適切な使用領域を公表し、十分な透明性の確保を支援する ことで、アカウンタビリティの向上に貢献する\n> 透明性報告書は、使用説明書や関連する技術的文書等とともに、最新に保たれるべき\nIV. 産業界、政府、市民社会、学界を含む、高度な AI システムを開発する組織間での責任ある情報共有と インシデントの報告に向けて取り組む\n> AI システムの安全性やセキュリティ等を確保するための共有の基準、メカニズムを開発、推進すべき。加えて、AI のライフサイクル全体にわたって、適切な文書化や他の主体との協力、関連情報の共有 や社会への報告を実施すべき\nV. 特に高度な AI システム開発者に向けた、個人情報保護方針及び緩和策を含む、リスクベースのアプロー チにもとづくAI ガバナンス及びリスク管理方針を策定し、実施し、開示する\n> 可能であれば、AI のライフサイクル全体を通じて、AI リスクを特定・評価・予防・対処するためのAI ガ バナンス方針を策定・実施・開示し、定期的に更新すべき。また、事業者の職員等に対する教育方針を確立すべき\nVI. AI のライフサイクル全体にわたり、物理的セキュリティ、サイバーセキュリティ、内部脅威に対する安全対策を含む、強固なセキュリティ管理に投資し、実施する\n\n[^0]\n[^0]: ${ }^{45}$ 広島 AI プロセスに関するG7 首脳声明「高度な AI システムを開発する組織向けの広島プロセス国際行動規範」(2023 年 10 月) なお、同文書は高度な AI システムにおける動向に対応して、既存の OECD AI 原則にもとづいて構築される living document であることに注意が必要である。\n https://www.mofa.go.jp/mofaj/files/100573472.pdf\n\n> 高度な AI システムのサイバーセキュリティリスクの評価や、適切で安全な環境での作業と文書保管の義務付けをすべき。無許可で公開されるリスク等に対応するための対策、知的財産や企業秘密の保護と整合性のある強固な内部脅威検知プログラムの確立すべき\nVII. 技術的に可能な場合は、電子透かしやその他の技術等、AI 利用者及び業務外利用者が、AI が生成し たコンテンツを識別できるようにするための、信頼できるコンテンツ認証及び来歴のメカニズムを開発し、導入 する\n> 透かしや識別子を利用することに加え、各主体がこの分野の状況を前進させるために協力し、研究 に投資すべき\nVIII. 社会的、安全、セキュリティ上のリスクを軽減するための研究を優先し、効果的な軽減策への投資を優先 する\n> 民主的価値の維持や人権の尊重、子どもや社会的弱者の保護等、リスクに対処するための優先的 な研究、協力等を行うべき。加えて、環境や気候への影響を含むリスクを積極的に管理し、リスクに関する研究とベストプラクティスを共有することを奨励\nIX. 世界の最大の課題、特に気候危機、世界保健、教育等(ただしこれらに限定されない)に対処するた め、高度な AI システムの開発を優先する\n> 個人や地域社会がAIの利用から利益を得るためのデジタル・リテラシーのイニシアティブを支援し、一般市民の教育と訓練を促進すべき。また、市民社会やコミュニティ・グループとの協力により、課題の特定や解決策を開発すべき\nX. 国際的な技術規格の開発を推進し、適切な場合にはその採用を推進する\n\n国際的な技術標準の開発に加え、AI が生成したコンテンツと他のコンテンツを区別できる技術標準を開発すべき\nXI. 適切なデータインプット対策を実施し、個人データ及び知的財産を保護する\n> データの質の管理のための適切な対策として、透明性、プライバシー保護のための機械学習や、機密 データ等の漏洩のテストとファインチューニングを含む対策を実施し、著作権で保護されたコンテンツを含め、プライバシーや知的財産等に関する権利を尊重するために適切なセーフガードの導入が奨励さ れる\n\n当該「行動規範」の遵守状況を高度なAIシステムを開発するAI 開発者自らが自主的に確認し報告する「報告枠組み」が OECD との協力の下、G7 で合意され、2025年2月より運用開始されている ${ }^{46}$ 。当該「行動規範」を遵守した高度なAIシステムを開発するAI 開発者は、「報告枠組み」に参加することが期待されている。\n\n[^0]\n[^0]: ${ }^{46}$ 広島プロセス国際行動規範「報告枠組み」 https://transparency.oecd.ai/\n"

}

]

},

{

"title": "第4部 AI 提供者に関する事項",

"node_id": "0029",

"page_index": 36,

"text": "### 第4部 AI 提供者に関する事項\n\nAI 提供者は、AI 開発者が開発するAIシステムに付加価値を加えてAIシステム・サービスをAI 利用者に提供する役割を担う。AIを社会に普及・発展させるとともに、社会経済の成長にも大きく寄与する一方で、社会に与える影響の大きさゆえに、AI 提供者は、AIの適正な利用を前提としたAIシステム・サービスの提供を実現す ることが重要となる。そのため、AIシステム・サービスに組み込むAIが当該システム・サービスに相応しいものか留意することに加え、ビジネス戦略又は社会環境の変化によってAIに対する期待値が変わることも考慮して、適切な変更管理、構成管理及びサービスの維持を行うことが重要である。\n\nAIシステム・サービスをAI 開発者が意図している範囲で実装し、正常稼働及び適正な運用を継続し、AI 開発者に対しては、AIシステムが適正に開発されるように求めることが重要である。AI 利用者に対しては、AIシス テムの提供及び運用のサポート又はAIシステムの運用をしつつAIサービスを提供することが重要である。提供 に際し、ステークホルダーの権利を侵害せず、かつ社会に不利益等を生じさせることがないように留意し、合理的 な範囲でインシデント事例等を含む関連情報の共有を行い、より安全安心で信頼できるAIシステム・サービス を提供することが期待される。\n\n以下にAI 提供者にとって、重要な事項を挙げる。\n\n#### - AIシステム実装時\n\n$>$ P-2) I. 人間の生命・身体・財産、精神及び環境に配慮したリスク対策\n$\\diamond \\quad$ AI 利用者を含む関連するステークホルダーの生命・身体・財産、精神及び環境に危害を及ぼ すことがないよう、提供時点で予想される利用条件下でのパフォーマンスだけでなく、様々な状況下でAIシステムがパフォーマンスレベルを維持できるようにし、リスク(連動するロボットの制御不能、不適切な出力等)を最小限に抑える方法(ガードレール技術等)を検討する(「2)安全性J)\n$>$ P-2) II. 適正利用に資する提供\n$\\diamond \\quad$ AIシステム・サービスの利用上の留意点を正しく定める(「2)安全性J)\n$\\diamond \\quad$ AI 開発者が設定した範囲でAIを活用する(「2)安全性J)\n$\\diamond$ 提供時点でAIシステム・サービスの正確性・必要な場合には学習データの最新性(データが適切であること)等を担保する(「2)安全性J)\n$\\diamond \\quad$ AI 開発者が設定したAIの想定利用環境とAIシステム・サービスの利用者の利用環境に違い等がないかを検討する(「2)安全性J)\n$>$ P-3) I. AIシステム・サービスの構成及びデータに含まれるバイアスへの配慮\n$\\diamond$ 提供時点でデータの公平性の担保及び参照する情報、連携する外部サービス等のバイアスを検討する(「3)公平性J)\n$\\diamond \\quad$ AIモデルの入出力及び判断根拠を定期的に評価し、バイアスの発生をモニタリングする。また、必要に応じて、AI 開発者にAIモデルを構成する各技術要素のバイアスの再評価、評価結果\n\nにもとづくAIモデル改善の判断を促す(「3)公平性」)\n$\\diamond$ AIモデルの出力結果を受け取るAIシステム・サービス、ユーザーインタフェースにおいて、ビジネス プロセス及びAI 利用者又は業務外利用者の判断を恣意的に制限するようなバイアスが含まれ てしまう可能性を検討する(「3)公平性」)\n$>$ P-4) I. プライバシー保護のための仕組み及び対策の導入\n$\\diamond$ AIシステムの実装の過程を通じて、採用する技術の特性に照らし適切に個人情報へのアクセス を管理・制限する仕組みの導入等のプライバシー保護のための対策を講ずる(プライバシー・バ イ・デザイン)(「4)プライバシー保護」)\n$>$ P-5) I. セキュリティ対策のための仕組みの導入\n$\\diamond$ AIシステム・サービスの提供の過程を通じて、採用する技術の特性に照らし適切にセキュリティ対策を講ずる(セキュリティ・バイ・デザイン)(「5)セキュリティ確保」)\n$>$ P-6) I. システムアーキテクチャ等の文書化\n$\\diamond$ トレーサビリティ及び透明性の向上のため、意思決定に影響を与える提供するAIシステム・サー ビスのシステムアーキテクチャ、データの処理プロセス等について文書化する(「6)透明性」)\n\n##### - AIシステム・サービス提供後\n\n$>$ P-2) II. 適正利用に資する提供\n$\\diamond$ 適切な目的でAIシステム・サービスが利用されているかを定期的に検証する(「2)安全性」)\n$>$ P-4) II. プライバシー侵害への対策\n$\\diamond$ AIシステム・サービスにおけるプライバシー侵害に関して適宜情報収集し、侵害を認識した場合等は適切に対処するとともに、再発の防止を検討する(「4)プライバシー保護」)\n$>$ P-5) II. 脆弱性への対応\n$\\diamond$ AIシステム・サービスに対する攻撃手法も数多く生まれているため、最新のリスク及びそれに対応 するために提供の各工程で気を付けるべき点の動向を確認する。また、脆弱性に対応すること を検討する(「5)セキュリティ確保」)\n$>$ P-6) II. 関連するステークホルダーへの情報提供\n$\\diamond$ 提供するAIシステム・サービスについて、例えば以下の事項を平易かつアクセスしやすい形で、適時かつ適切に情報を提供する(「6)透明性」)\n\n- AI を利用しているという事実、活用している範囲、適切/不適切な使用方法等(「6)透明性」)\n- 提供するAIシステム・サービスの技術的特性、利用によりもたらす結果より生じる可能性 のある予見可能なリスク及びその緩和策等の安全性に関する情報(「2)安全性」)\n\n- AI システム・サービスの学習等による出力又はプログラムの変化の可能性(「1)人間中心」)\n- AI システム・サービスの動作状況に関する情報、不具合の原因及び対応状況、インシデ ント事例等(「2)安全性」)\n- AIシステムの更新を行った場合の更新内容及びその理由の情報(「2)安全性」)\n- AIモデルにて学習するデータの収集ボリシー、学習方法、実施体制等(「3)公平性」、「4)プライバシー保護」、「5)セキュリティ確保」)\n$>$ P-7) i. AI 利用者への「共通の指針」の対応状況の説明\n$\\diamond \\mathrm{AI}$ 利用者に適正利用を促し、以下の情報をAI 利用者に提供する(「7)アカウンタビリテ イ」)\n- 正確性・必要な場合には最新性(データが適切であること)等が担保されたデータの利用についての注意喚起(「2)安全性」)\n- コンテキスト内学習による不適切なAIモデルの学習に対する注意喚起(「2)安全性」)\n- 個人情報を入力する際の留意点(「4)プライバシー保護」)\n$\\diamond$ 提供するAIシステム・サービスへの個人情報の不適切入力について注意喚起する(「4)プラ イバシー保護」)\nP-7) ii. サービス規約等の文書化\n$\\diamond \\mathrm{AI}$ 利用者又は業務外利用者に向けたサービス規約を作成する(「7)アカウンタビリティ」)\n$\\diamond$ プライバシーポリシーを明示する(「7)アカウンタビリティ」)\n\nなお、高度なAIシステムを取り扱うAI 提供者は、「第2部D、高度なAIシステムに関係する事業者に共通の指針」について以下のように対応する。\n\n- I)〜XI)適切な範囲で遵守すべきである\n- XII)遵守すべきである\n"

},

{

"title": "第5部 AI 利用者に関する事項",

"node_id": "0030",

"page_index": 39,

"text": "### 第5部 AI 利用者に関する事項\n\nAI 利用者は、AI 提供者から安全安心で信頼できるAIシステム・サービスの提供を受け、AI 提供者が意図し た範囲内で継続的に適正利用及び必要に応じてAIシステムの運用を行うことが重要である。これにより業務効率化、生産性・創造性の向上等AIによるイノベーションの最大の恩恵を受けることが可能となる。また、人間の判断を介在させることにより、人間の尊厳及び自律を守りながら予期せぬ事故を防ぐことも可能となる。\n\nAI 利用者は、社会又はステークホルダーからAIの能力又は出力結果に関して説明を求められた場合、AI提供者等のサポートを得てその要望に応え理解を得ることが期待され、より効果的なAI 利用のために必要な知見習得も期待される。\n\n以下にAI 利用者にとって、重要な事項を挙げる。\n\n#### - AIシステム・サービス利用時\n\n$>$ U-2) i. 安全を考慮した適正利用\n$\\diamond$ AI 提供者が定めた利用上の留意点を遵守して、AI 提供者が設計において想定した範囲内で AIシステム・サービスを利用する(「2)安全性」)\n$\\diamond$ 正確性・必要な場合には最新性(データが適切であること)等が担保されたデータの入力を行う(「2)安全性」)\n$\\diamond$ AI の出力について精度及びリスクの程度を理解し、様々なリスク要因を確認した上で利用する\n(「2)安全性」)\n$>$ U-3) i. 入力データ又はプロンプトに含まれるバイアスへの配慮\n$\\diamond$ 著しく公平性を欠くことがないよう公平性が担保されたデータの入力を行い、プロンプトに含まれ るバイアスに留意して、責任をもってAI 出力結果の事業利用判断を行う(「3)公平性」)\n$>$ U-4) i. 個人情報の不適切入力及びプライバシー侵害への対策\n$\\diamond$ AIシステム・サービスへ個人情報を不適切に入力することがないよう注意を払う(「4)プライバ シー保護」)\n$\\diamond$ AIシステム・サービスにおけるプライバシー侵害に関して適宜情報収集し、防止を検討する\n(「4)プライバシー保護」)\n$>$ U-5) i. セキュリティ対策の実施\n$\\diamond$ AI 提供者によるセキュリティ上の留意点を遵守する(「5)セキュリティ確保」)\n$\\diamond$ AIシステム・サービスに機密情報等を不適切に入力することがないよう注意を払う(「5)セキュ リティ確保」)\n$>$ U-6) i. 関連するステークホルダーへの情報提供\n\n* 著しく公平性を欠くことがないよう、公平性が担保されたデータの入力を行い、プロンプトに含ま れるバイアスに留意してAIシステム・サービスから出力結果を取得する。そして、出力結果を事業判断に活用した際は、その結果を関連するステークホルダーに合理的な範囲で情報を提供 する(「3)公平性」、「6)透明性」)\n$>U-7) \\mathrm{i}$ 、関連するステークホルダーへの説明\n* 関連するステークホルダーの性質に応じて合理的な範囲で、適正な利用方法を含む情報提供 を平易かつアクセスしやすい形で行う(「7)アカウンタビリティ」)\n* 関連するステークホルダーから提供されるデータを用いることが予定されている場合には、AI の特性及び用途、データの提供元となる関連するステークホルダーとの接点、プライバシーポリシー等 を踏まえ、データ提供の手段、形式等について、あらかじめ当該ステークホルダーに情報提供す る(「7)アカウンタビリティ」)\n* 当該AIの出力結果を特定の個人又は集団に対する評価の参考にする場合は、AI を利用し ている旨を評価対象となっている当該特定の個人又は集団に対して通知し、当ガイドラインが推奨する出力結果の正確性、公正さ、透明性等を担保するための諸手続きを遵守し、かつ自動化バイアスも鑑みて人間による合理的な判断のもと、評価の対象となつた個人又は集団から の求めに応じて説明責任を果たす(「1)人間中心」、「6)透明性」、「7)アカウンタビリテ イ」)\n* 利用するAIシステム・サービスの性質に応じて、関連するステークホルダーからの問合せに対応 する窓口を合理的な範囲で設置し、AI 提供者とも連携の上説明及び要望の受付を行う\n(「7)アカウンタビリティ」)\n$>U-7) \\mathrm{II}$ 、提供された文書の活用及び規約の遵守\n* AI 提供者から提供されたAIシステム・サービスについての文書を適切に保管・活用する(「7) アカウンタビリティ」)\n* AI 提供者が定めたサービス規約を遵守する(「7)アカウンタビリティ」)\n\nなお、高度なAIシステムを取り扱うAI 利用者は、「第2部D、高度なAIシステムに関係する事業者に共通の指針」について以下のように対応する。\n\n- I)〜XI)適切な範囲で遵守すべきである\n- XII)遵守すべきである\n"

}

]

}

]

}JSONの構造について

PageIndexの Tree 結果は、文書全体を階層的に整理した 木構造のJSON として返されます。

トップレベルでは status や result を含み、result の中に文書全体を表すルートノードが格納されています。

各ノードは章・節・小節の関係を nodes で入れ子構造として持っています。

-

上位オブジェクト(Tree応答のルート)

キー 説明 例 doc_idPageIndex上の文書ID "pi-cmgf..."status処理状態( completed/processing/failed)"completed"retrieval_readyRetrieval機能が利用可能か trueresult文書のルートノードを含む配列(通常は1要素) [ { ...Node... } ] -

ノード(Nodeオブジェクト)

キー 説明 例 title見出しタイトル "AI 事業者ガイドライン"node_idノードの一意なID "0000"page_index出現ページ番号(1起点) 1text見出しと本文テキスト(Markdown形式) ### 第1部 AIとは\n...nodes子ノード(章・節・小節などの下位項目) [ { ... }, { ... } ] -

基本的な構造

{ "doc_id": "string", "status": "completed", "retrieval_ready": true, "result": [ { "title": "string", "node_id": "string", "page_index": 1, "text": "string", "nodes": [ /* 子ノード */ ] } ] }

5. Retrieval を実行(単一ドキュメント検索)

このコードでは、アップロード済みの文書に対してクエリを投げ、該当箇所(ノード)を抽出します。

Retrieval(検索)機能は、PageIndexが生成したツリー構造をもとに、質問内容に関連する見出しやテキストを返す仕組みです。

# Retrieval(単一ドキュメント検索)— 旧API名に合わせる

import time

# 例1: 基本理念の要約(ページ番号付き)

query = "第2部A 基本理念の要点を抽出して"

# 例2: 共通の指針(箇条書き)

# query = "第2部C 共通の指針の見出しと要点を抽出して(1)〜10)の番号保持)"

# 例3: 開発者の重要事項だけ

# query = "第3部 AI開発者に関する事項のうち D-2 と D-3 の要点を抽出して"

# 例4: 提供者の運用時の注意

# query = "第4部 AI提供者に関する事項のうち 提供後の留意点(P-4ii, P-5ii, P-6ii, P-7)を抽出して"

# 例5: 利用者の適正利用

# query = "第5部 AI利用者の U-2 と U-3 の要点を抽出して"

# 例6: 文書版と日付

# query = "文書の版番号と公表日を特定して"

if not pi.is_retrieval_ready(doc_id):

raise RuntimeError("Retrieval not ready")

def run_retrieval_legacy(doc_id: str, query: str, interval: int = 3):

# 旧API名: submit_query -> retrieval_id を返す

job = pi.submit_query(doc_id, query)

rid = job["retrieval_id"]

while True:

# 旧API名: get_retrieval -> status が completed になるまで待つ

rr = pi.get_retrieval(rid)

st = rr.get("status")

if st == "completed":

return rr

if st == "failed":

raise RuntimeError("Retrieval failed")

time.sleep(interval)

rr = run_retrieval_legacy(doc_id, query)

nodes = rr.get("retrieved_nodes", [])

print("Retrieved nodes:", len(nodes))

nodes[:1]コード解説

query = "第2部A 基本理念の要点を抽出して"検索対象の質問文を定義しています。

if not pi.is_retrieval_ready(doc_id):

raise RuntimeError("Retrieval not ready")指定した文書がRetrieval可能な状態(OCRとTree生成が完了済み)かを確認しています。

未完了の場合は実行を停止します。

def run_retrieval_legacy(doc_id: str, query: str, interval: int = 3):

job = pi.submit_query(doc_id, query)

rid = job["retrieval_id"]

submit_query() で検索ジョブを送信し、PageIndexクラウド側で非同期検索を実行します。

返ってきた "retrieval_id" は、この検索処理を追跡するためのIDです。

while True:

rr = pi.get_retrieval(rid)

st = rr.get("status")

if st == "completed":

return rr検索結果のステータスを確認し、完了したら結果オブジェクトを返します。

このループにより、処理が終わるまでポーリング(繰り返し確認)を行っています。

rr = run_retrieval_legacy(doc_id, query)

nodes = rr.get("retrieved_nodes", [])

print("Retrieved nodes:", len(nodes))

nodes[:1]

Retrievalの結果を取得し、関連ノードを retrieved_nodes として受け取ります。

ノード数を確認し、先頭の要素を簡易表示して、正しく検索できているかを確認します。

出力は以下のようになりました。

Retrieved nodes: 5

[{'id': '0010',

'title': '第2部 AIにより目指すべき社会及び各主体が取り組む事項',

'metadata': ['pi-cmg6vclyh00000er3hxgwkvyz',

'sample.pdf',

'',

'This document is the official Japanese government guideline (version 1.1, March 28, 2025) for AI business operators, detailing principles, roles, and practical measures for the responsible development, provision, and use of AI systems—covering human-centricity, safety, fairness, privacy, security, transparency, accountability, and governance—across the entire AI lifecycle, and is jointly issued by the Ministry of Internal Affairs and Communications and the Ministry of Economy, Trade and Industry.',

'File',

'',

'',

'',

''],

'relevant_contents': [[{'section_title': '第2部 AIにより目指すべき社会及び各主体が取り組む事項',

'physical_index': '<physical_index_12>',

'relevant_content': '第2部では、まず、AIにより目指す社会としての「A. 基本理念」を記載する。更に、その実現に向け、各主体が取り組む「B. 原則」とともに、そこから導き出される「C. 共通の指針」を記載する。また、高度なAIシステムに関係する事業者が遵守すべき「D. 高度なAIシステムに関係する事業者に共通の指針」を記載する。加えて、この「C. 共通の指針」を実践しAIを安全安心に活用していくために重要な「E. AI ガバナンスの構築」についても記載する。'}]]}]出力結果では、PageIndexがクエリに関連すると判断した章ノードが5件抽出されています。

title は該当章の見出し、metadata には文書の基本情報(ファイル名や説明など)、

relevant_contents には実際にヒットした本文の抜粋が含まれています。

つまり、この結果から「どの章が回答根拠になったか」と「対応する本文内容」を確認できます。

6. 根拠テキストを整形

このコードでは、Retrievalの結果から抽出したノード情報を整形し、LLM(Gemini)に入力できるテキスト形式に変換しています。

from collections.abc import Iterable

def extract_nodes(rr: dict | list) -> list:

"""Retrieval応答からノード配列を安全取得"""

if isinstance(rr, list):

return rr

return rr.get("retrieved_nodes") or rr.get("nodes") or rr.get("result") or []

def flatten(iterable):

"""一次元へフラット化(文字列は分解しない)"""

stack = list(iterable)

out = []

while stack:

x = stack.pop(0)

if isinstance(x, list):

stack[0:0] = x

else:

out.append(x)

return out

def iter_relevant_items(node: dict):

"""ノードから関連項目を反復。文字列/辞書どちらも返す"""

rcs = (

node.get("relevant_contents")

or node.get("contents")

or node.get("relevant_content")

or []

)

if isinstance(rcs, dict):

rcs = rcs.get("items", [])

return flatten(rcs)

def build_context_from_nodes(nodes: list, max_items: int = 12) -> str:

ctx = []

for n in nodes:

for rc in iter_relevant_items(n):

# 文字列要素

if isinstance(rc, str):

text = rc.strip()

if not text:

continue

ctx.append(f"[p.?] {text}")

# 辞書要素

elif isinstance(rc, dict):

page = rc.get("page_index") or rc.get("page") or rc.get("page_idx")

text = (rc.get("relevant_content") or rc.get("content") or rc.get("text") or "").strip()

if not text:

continue

ptag = f"p.{page}" if page is not None else "p.?"

ctx.append(f"[{ptag}] {text}")

# その他は無視

else:

continue

if len(ctx) >= max_items:

return "\n".join(ctx)

return "\n".join(ctx)

# 実行

nodes = extract_nodes(rr)

# デバッグ: relevant item の型を観察(最初の数件)

if nodes:

sample_items = iter_relevant_items(nodes[0])

sample_items = list(sample_items)[:3]

print("sample item types:", [type(x).__name__ for x in sample_items])

context_text = build_context_from_nodes(nodes, max_items=20)

print("lines:", len(context_text.splitlines()))

print(*context_text.splitlines()[:5], sep="\n")コード解説

extract_nodes()

Retrieval応答 (rr) からノード配列だけを安全に取り出します。

APIバージョンによってキー名が異なるため、retrieved_nodes / nodes / result のいずれにも対応できるようにしています。

def flatten(iterable):多重リストを一次元にまとめる補助関数です。

PageIndexの出力は、配列がネストしていることが多いため、文字列単位で扱えるように整形します。

def iter_relevant_items(node: dict):

各ノードから "relevant_contents"(検索にヒットした本文部分)を取り出します。

キー名の揺れにも対応し、最終的にテキストの配列を返すようにしています。

def build_context_from_nodes(nodes: list, max_items: int = 12) -> str:取得したノード群をもとに、本文テキストを整形します。

本文の先頭に [p.?] を付けてページ番号を示し、複数ノードの内容を1つのテキストブロックに統合します。

max_items で取り込む文数を制限し、長文の入力を防いでいます。

nodes = extract_nodes(rr)

context_text = build_context_from_nodes(nodes, max_items=20)

Retrieval結果から関連ノードを抽出し、本文だけを結合した context_text を生成しています。

このテキストが、次のステップ(Geminiによる要約生成)の入力となります。

if nodes:

sample_items = iter_relevant_items(nodes[0])

sample_items = list(sample_items)[:3]

print("sample item types:", [type(x).__name__ for x in sample_items])

context_text = build_context_from_nodes(nodes, max_items=20)

print("lines:", len(context_text.splitlines()))

print(*context_text.splitlines()[:5], sep="\n")この部分では、Retrieval結果から取り出したノード構造を確認し、テキスト整形が正しく行われているかを簡単に検証しています。

まず、iter_relevant_items() を使って最初のノード内の要素を数件だけチェックし、要素の型(多くは dict)を確認します。

続いて、build_context_from_nodes() で本文を整形し、生成された行数と冒頭の数行を出力します。

これにより、Geminiに渡すためのテキストが正しく抽出・結合されていることを目視で確認できます。

出力は以下のようになりました。

sample item types: ['dict']

lines: 6

[p.?] 第2部では、まず、AIにより目指す社会としての「A. 基本理念」を記載する。更に、その実現に向け、各主体が取り組む「B. 原則」とともに、そこから導き出される「C. 共通の指針」を記載する。また、高度なAIシステムに関係する事業者が遵守すべき「D. 高度なAIシステムに関係する事業者に共通の指針」を記載する。加えて、この「C. 共通の指針」を実践しAIを安全安心に活用していくために重要な「E. AI ガバナンスの構築」についても記載する。

[p.?] 我が国が2019年3月に策定した「人間中心のAI社会原則」において、AIがSociety 5.0の実現に貢献することが期待されている。AIを人類の公共財として活用し、社会の質的変化及び真のイノベーションを通じて地球規模の持続可能性とつなげることが重要である。以下の3つの価値を「基本理念」として尊重し、その実現を追求する社会を構築すべきとされている。 (1) 人間の尊厳が尊重される社会(Dignity):AIに過度に依存せず、人間がAIを道具として使いこなし、人間の能力や創造性を発揮し、物質的・精神的に豊かな生活を送る社会を構築する必要がある。 (2) 多様な背景を持つ人々が多様な幸せを追求できる社会(Diversity and Inclusion):多様な価値観を包摂し新たな価値を創造できる社会を目指し、AIの適正な開発と展開によって社会の在り方を変革する必要がある。 (3) 持続可能な社会(Sustainability):AI活用により社会の格差解消や地球規模の環境問題・気候変動に対応可能な持続性のある社会を構築し、科学技術立国としての責務を果たす必要がある。

[p.?] AI の活用により目指すべき社会及びそれを実現するための「基本理念」(why)、並びに原則及び各主体に共通する指針(what)を記載する。AI の活用による便益を求める中で、AI が社会にリスクをもたらす可能性を鑑み、「共通の指針」を実践するために必要となるガバナンスの構築についても触れる。第2部では第3部以降のもととなる内容を解説しているため、AI を活用する全ての事業者が内容を確認し、理解することが重要である。

[p.?] 「基本理念」を実現するためには、各主体がこれに沿う形で取組を進めることが重要であり、そのために各主体が念頭におく「原則」を、各主体が取り組む事項及び社会と連携した取組が期待される事項に整理した。この「原則」は、「人間中心の AI 社会原則」を土台としつつ、OECD の AI 原則等の海外の諸原則を踏まえ、再構成したものである。 各主体が取り組む事項 各主体は、「基本理念」より導き出される人間中心の考え方をもとに、AIシステム・サービスの開発・提供・利用を促進し、人間の尊厳を守りながら、事業における価値の創出、社会課題の解決等、AI の目的を実現していくことが重要である。このため、各主体は、AI 活用に伴う社会的リスクの低減を図るべく、安全性・公平性といった価値を確保することが重要である。また、個人情報の不適正な利用等の防止を始めとするプライバシー保護、並びにAIシステムの脆弱性等による可用性の低下及び外部からの攻撃等のリスクに対応するセキュリティ確保を行うことが重要である。これらを実現するために、各主体は、システムの検証可能性を確保しながらステークホルダーに対する適切な情報を提供することにより透明性を向上させ、アカウンタビリティを果たすことが重要となる。 加えて、今後、AIアーキテクチャの多様化に伴うバリューチェーン変動等により、各主体の役割が変動する可能性を踏まえた上で、各主体間で連携し、バリューチェーン全体でのAIの品質の向上に努めること及びマルチステークホルダーで継続して議論していくことが重要である。このような対応を行うことで、各主体が、AIのリスクを最低限に抑制しつつ、AIシステム・サービスの開発・提供・利用を通じて最大限の便益を享受することが期待される。 社会と連携した取組が期待される事項 AIによる社会への便益を一層増大させ、我々が目指すべき「基本理念」を実現していくためには、各主体それぞれの取組に加え、社会(政府・自治体及びコミュニティも含む)と積極的に連携することが期待される。このため、各主体は、社会と連携して、社会の分断を回避し、全ての人々にAIの恩恵が行き渡るための教育・リテラシー確保の機会を提供することが期待される。加えて、新たなビジネス・サービスが創出され、持続的な経済成長の維持及び社会課題の解決策が提示されるよう、公正競争の確保及びイノベーションの促進に貢献していくことが期待される。

[p.?] 第3部では、第2部で触れられないAIを活用する3つの主体(AI開発者、AI提供者、AI利用者)それぞれの留意点を記載しているが、これらの主体は第1部、第2部の基本理念(why)及び指針(what)を踏まえてリスク対応方針を理解し、実践することが重要である。特に経営者を含む事業執行責任者は、第2部の基本理念を基に事業戦略と一体でAI活用のリスク対策を検討・実践し、安全安心なAI活用を推進することが求められている。-

sample item types: ['dict']各要素が辞書形式(page, relevant_content などを持つ)であることを確認しています。

-

lines: 6整形後のテキストが6段落にまとめられたことを示しています。

-

[p.?]ページ番号が不明な場合の仮タグです。PageIndexの出力にページ情報が含まれていれば

(p.xx)として表示されます。

結果として、Geminiが理解しやすい形で 「どのページ・どの章から抽出された本文か」 を明示した入力テキストが生成されています。

7. Gemini で最終回答生成

このコードでは、整形済みのテキスト (context_text) と質問 (query) を Gemini に入力し、要約・抽出回答を生成します。

prompt = f"""あなたは厳密な要約器。次の根拠テキストの内容だけで質問に回答せよ。

- 箇条書きで短く。

- 文書の表記(例: 第2部C, D-2, U-3 など)は可能な限り保持。

- 各項目の末尾に根拠ページを (p.xx) で付す。

- 想像や外挿はしない。根拠が無ければ「根拠不足」と書く。

- 出力は日本語のみ。

# 質問

{query}

# 根拠

{context_text}

"""

resp = gclient.models.generate_content(

model="gemini-2.0-flash-001",

contents=prompt

)

print(resp.text)コード解説

この部分では、Geminiに渡すプロンプト(入力文)を構築しています。

query はユーザが入力した質問、context_text はPageIndexから抽出した根拠文です。

resp = gclient.models.generate_content(

model="gemini-2.0-flash-001",

contents=prompt

)

print(resp.text)ここでGemini APIを呼び出し、実際の回答を生成します。

最終的に要約・回答がコンソールに出力されます。

出力は以下のようになりました。

第2部A 基本理念の要点:

* AIにより目指す社会としての「A. 基本理念」を記載 (p.?)

* 「人間中心のAI社会原則」において、AIがSociety 5.0の実現に貢献することが期待されている (p.?)

* 人類の公共財としてAIを活用し、社会の質的変化及び真のイノベーションを通じて地球規模の持続可能性とつなげることが重要 (p.?)

* 3つの価値を「基本理念」とする:

* (1) 人間の尊厳が尊重される社会(Dignity) (p.?)

* (2) 多様な背景を持つ人々が多様な幸せを追求できる社会(Diversity and Inclusion) (p.?)

* (3) 持続可能な社会(Sustainability) (p.?)

* 「基本理念」を実現するためには、各主体がこれに沿う形で取組を進めることが重要 (p.?)

* 各主体は、AI活用に伴う社会的リスクの低減を図るべく、安全性・公平性といった価値を確保することが重要 (p.?)

* 各主体は、社会と連携して、社会の分断を回避し、全ての人々にAIの恩恵が行き渡るための教育・リテラシー確保の機会を提供することが期待される (p.?)

* 経営者を含む事業執行責任者は、第2部の基本理念を基に事業戦略と一体でAI活用のリスク対策を検討・実践し、安全安心なAI活用を推進することが求められている (p.?)作業上の注意点

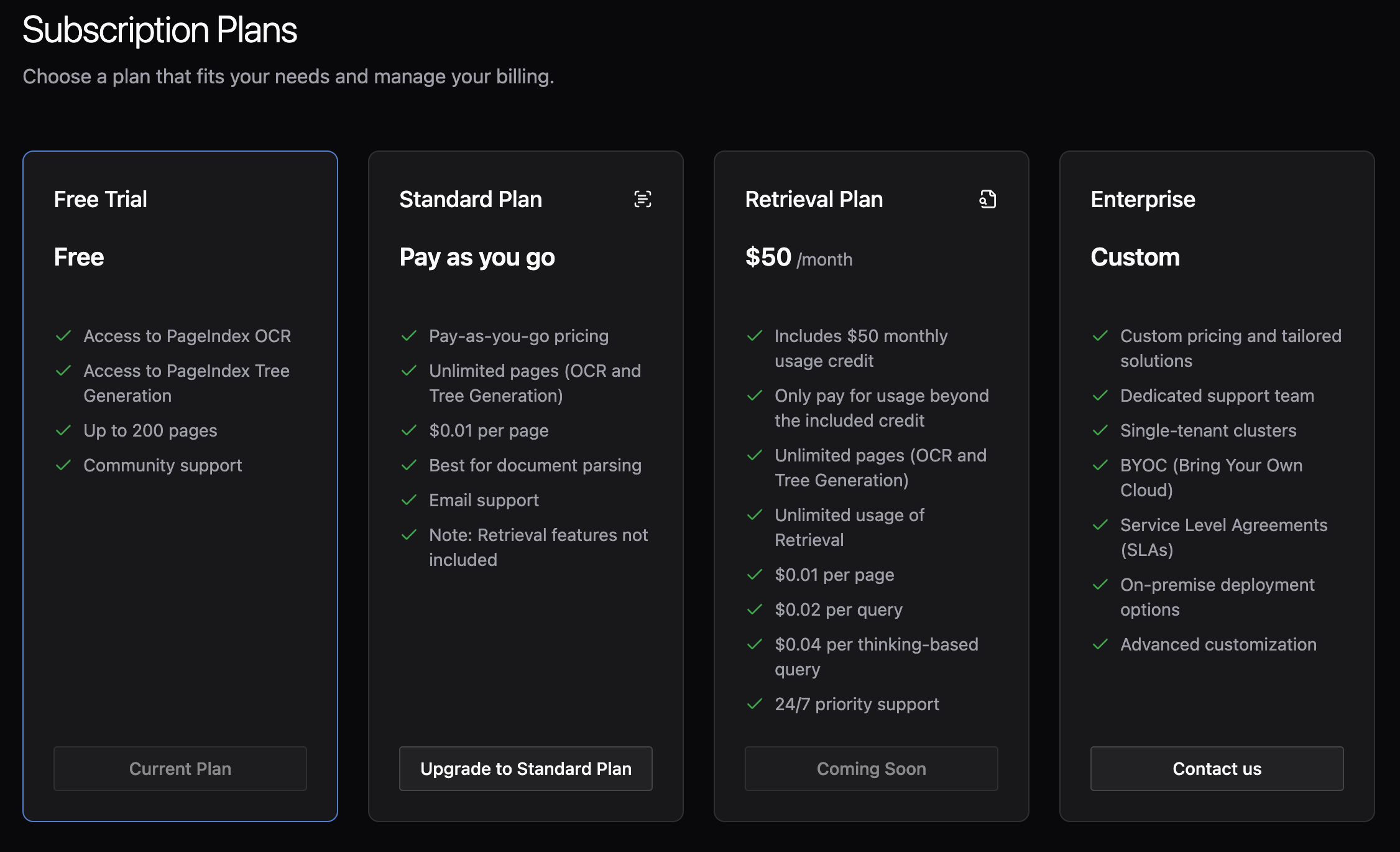

Free Trial では 最大 200 ページ まで処理可能(OCR + Tree 生成含む)です。

おわりに

この記事では、PageIndex の構造探索型 RAG 手法を、OCR・ツリー生成・検索という 3 機能を通じて解説しました。

ベクトルDBとの比較で、構造を活かした探索がもたらす文脈保持性・根拠明示性・処理の軽さを確認できたと思います。

今回は SaaS 版(Python SDK 経由でクラウド API を利用する形)を使って動かしましたが、PageIndex 本体は OSS としても公開されており、ご自身の環境で安全に、あるいはカスタマイズして使うことも可能です。

さらに、PDF をチャット形式で扱えるようにする PageIndex MCP も公開されており、文書を LLMやAIエージェントと対話形式で扱う機能も将来的に使いやすくなっていくかと思います。

あなたの手元の文書でも、ぜひ試してみて、その有効性を体感していただければ幸いです。